Object Gateway 가이드

Ceph Object Gateway 배포, 구성 및 관리

초록

1장. Ceph Object Gateway

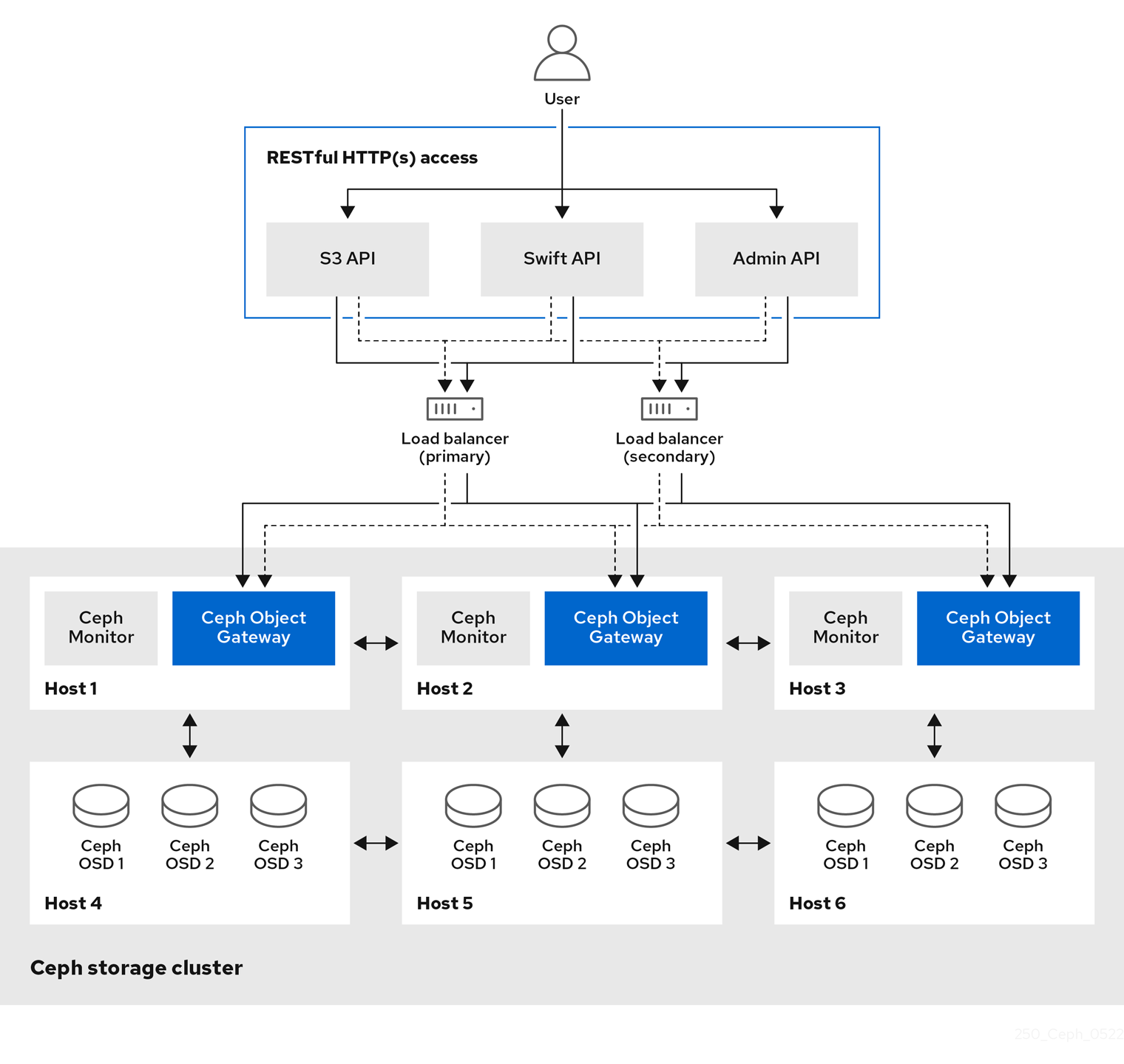

Ceph Object Gateway(RGW)는 Ceph 스토리지 클러스터에 대한 RESTful 게이트웨이를 애플리케이션에 제공하기 위해 librados 라이브러리에 빌드된 오브젝트 스토리지 인터페이스입니다. Ceph Object Gateway는 다음 세 가지 인터페이스를 지원합니다.

S3 호환성:

Amazon S3 RESTful API의 큰 하위 집합과 호환되는 인터페이스가 포함된 오브젝트 스토리지 기능을 제공합니다.

S3 select를 실행하여 처리량을 가속화할 수 있습니다. 사용자는 중재자 없이 S3 선택 쿼리를 직접 실행할 수 있습니다. CSV용 S3 선택 워크플로우는 두 가지로, 하나는 Apache Parquet(Parquet)용이고, 하나는 S3 select 작업에 CSV 및 Parquet 오브젝트를 제공합니다. 이러한 S3 선택 작업에 대한 자세한 내용은 Red Hat Ceph Storage 개발자 가이드의 S3 선택 작업을 참조하십시오.

Swift 호환성:

OpenStack Swift API의 대규모 하위 집합과 호환되는 인터페이스가 포함된 오브젝트 스토리지 기능을 제공합니다.

Ceph Object Gateway는 Ceph 스토리지 클러스터와 상호 작용하는 서비스입니다. 이 솔루션은 OpenStack Swift 및 Amazon S3과 호환되는 인터페이스를 제공하므로 Ceph Object Gateway에는 자체 사용자 관리 시스템이 있습니다. Ceph Object Gateway는 Ceph 블록 장치 클라이언트에서 데이터를 저장하는 데 사용되는 동일한 Ceph 스토리지 클러스터에 데이터를 저장할 수 있지만 별도의 풀이 사용되며 다른 CRUSH 계층 구조도 사용할 수 있습니다. S3 및 Swift API는 공통 네임스페이스를 공유하므로 하나의 API로 데이터를 작성하고 다른 API에서 검색할 수 있습니다.

관리 API:

Ceph Object Gateways를 관리하기 위한 관리 인터페이스를 제공합니다.

관리 API 요청은 admin 리소스 엔드포인트로 시작하는 URI에서 수행됩니다. 관리 API에 대한 권한 부여는 S3 권한 부여 메커니즘을 복제합니다. 일부 작업에는 사용자에게 특별한 관리 기능이 있어야 합니다. 응답 유형은 요청에 format 옵션을 지정하여 XML 또는 JSON일 수 있지만 기본값은 JSON 형식입니다.

WORM 소개

WORM(Write-Once-Read-Many)은 프로덕션 영역에서 오브젝트 및 버킷이 손상된 경우에도 데이터 보호 및 데이터 검색을 보장하는 데 사용되는 보안 데이터 스토리지 모델입니다.

Red Hat Ceph Storage에서는 WORM(Write-Once-Read-Many) 모델을 사용하여 오브젝트 및 버킷을 저장하는 데 사용되는 읽기 전용 기능이 있는 S3 Object Lock을 사용하여 데이터 보안을 수행하여 삭제 또는 덮어쓸 수 없습니다. Red Hat Ceph Storage 관리자도 삭제할 수 없습니다.

S3 Object Lock은 다음 두 가지 보존 모드를 제공합니다.

- 거버넌스

- 컴플라이언스

이러한 보존 모드는 오브젝트에 다양한 수준의 보호 기능을 적용합니다. Object Lock으로 보호되는 모든 오브젝트 버전에 보존 모드를 적용할 수 있습니다.

GOVERNANCE에서는 특별한 권한이 없는 경우 오브젝트 버전을 덮어쓰거나 삭제하거나 잠금 설정을 변경할 수 없습니다. GOVERNANCE 모드에서는 오브젝트를 대부분의 사용자가 삭제하지 않도록 보호할 수 있지만, 필요한 경우 일부 사용자에게 보존 설정을 변경하거나 오브젝트를 삭제할 수 있는 권한을 부여할 수 있습니다.

COMPLIANCE 모드에서는 보호된 오브젝트 버전을 사용자가 덮어쓰거나 삭제할 수 없습니다. 개체가 COMPLIANCE 모드에서 잠긴 경우 해당 보존 모드를 변경하거나 줄일 수 없습니다.

2장. 고려 사항 및 권장 사항

스토리지 관리자는 Ceph Object Gateway를 실행하고 다중 사이트 Ceph Object Gateway 솔루션을 구현하기 전에 고려해야 할 사항을 기본적으로 이해하는 것이 중요합니다. 하드웨어 및 네트워크 요구 사항을 알아보고 Ceph Object Gateway와 함께 작동하는 워크로드 유형과 Red Hat의 권장 사항을 파악할 수 있습니다.

사전 요구 사항

- 스토리지 솔루션을 이해, 검토, 계획합니다.

2.1. Red Hat Ceph Storage의 네트워크 고려 사항

클라우드 스토리지 솔루션의 중요한 측면은 네트워크 대기 시간 및 기타 요인으로 인해 스토리지 클러스터가 IOPS에서 실행될 수 있다는 것입니다. 또한 스토리지 클러스터에 스토리지 용량이 부족하기 전에 대역폭 제약으로 인해 처리량이 부족할 수 있습니다. 즉, 네트워크 하드웨어 구성이 가격 대비 성능 요구 사항을 충족하기 위해 선택한 워크로드를 지원해야 합니다.

스토리지 관리자는 스토리지 클러스터를 최대한 빨리 복구하는 것을 선호합니다. 저장소 클러스터 네트워크에 대한 대역폭 요구 사항을 신중하게 고려하고 네트워크 링크 초과 서브스크립션에 유의하고 클러스터 내 트래픽을 클라이언트 간 트래픽에서 분리합니다. 또한 SSD(Solid State Disk), 플래시, NVMe 및 기타 고성능 저장 장치의 사용을 고려할 때 네트워크 성능이 점점 더 중요해진다는 점을 고려하십시오.

Ceph는 공용 네트워크 및 스토리지 클러스터 네트워크를 지원합니다. 공용 네트워크는 Ceph 모니터와의 통신 및 클라이언트 트래픽을 처리합니다. 스토리지 클러스터 네트워크는 Ceph OSD 하트비트, 복제, 백필, 복구 트래픽을 처리합니다. 최소한 하나의 10GB 이더넷 링크를 스토리지 하드웨어에 사용해야 하며 연결 및 처리량을 위해 10GB 이더넷 링크를 추가할 수 있습니다.

Red Hat은 복제된 풀에서 여러 기본으로 osd_pool_default_size 를 사용하여 공용 네트워크의 배수가 되도록 대역폭을 스토리지 클러스터 네트워크에 할당할 것을 권장합니다. 또한 별도의 네트워크 카드에서 공용 및 스토리지 클러스터 네트워크를 실행하는 것이 좋습니다.

Red Hat은 프로덕션 환경에서 Red Hat Ceph Storage 배포에 10GB 이더넷을 사용할 것을 권장합니다. 1GB 이더넷 네트워크는 프로덕션 스토리지 클러스터에 적합하지 않습니다.

드라이브 오류가 발생하는 경우 1GB 이더넷 네트워크에서 1TB의 데이터를 복제하는 데 3시간이 걸리며 3TB의 데이터를 9시간이 소요됩니다. 3TB를 사용하는 것이 일반적인 드라이브 구성입니다. 반면 10GB 이더넷 네트워크를 사용하면 복제 시간은 20분과 1시간입니다. Ceph OSD가 실패하면 스토리지 클러스터는 실패한 OSD와 동일한 장애 도메인 및 장치 클래스 내의 다른 OSD에 포함된 데이터를 복제하여 복구됩니다.

랙과 같은 대규모 도메인에 장애가 발생하면 스토리지 클러스터가 훨씬 더 많은 대역폭을 사용한다는 것을 의미합니다. 대규모 스토리지 구현에 공통적인 여러 랙으로 구성된 스토리지 클러스터를 구축할 때 최적의 성능을 위해 "팻 트리" 설계의 스위치 간 네트워크 대역폭을 최대한 활용하는 것이 좋습니다. 일반적인 10GB 이더넷 스위치에는 48개의 10GB 포트와 40GB 포트 4개가 있습니다. 최대 처리량을 위해 스파인에서 40GB 포트를 사용합니다. 또는 다른 랙 및 스파인 라우터에 연결하기 위해 사용하지 않는 10GB 포트를 40GB 이상의 포트로 집계하는 것이 좋습니다. 또한 네트워크 인터페이스를 결합하는 데 LACP 모드 4를 사용하는 것이 좋습니다. 또한, 특히 백엔드 또는 클러스터 네트워크에서 최대 전송 단위(MTU)가 9000인 점보 프레임을 사용합니다.

Red Hat Ceph Storage 클러스터를 설치하고 테스트하기 전에 네트워크 처리량을 확인합니다. Ceph에서 대부분의 성능 관련 문제는 일반적으로 네트워킹 문제로 시작합니다. kinked 또는 bent cat-6 케이블과 같은 간단한 네트워크 문제로 인해 대역폭이 저하될 수 있습니다. 전면 네트워크에 최소 10GB 이더넷을 사용합니다. 대규모 클러스터의 경우 백엔드 또는 클러스터 네트워크에 40GB 이더넷을 사용하는 것이 좋습니다.

네트워크 최적화를 위해 Red Hat은 대역폭당 CPU를 개선하고 차단되지 않는 네트워크 스위치 백 플레인에 점보 프레임을 사용하는 것이 좋습니다. Red Hat Ceph Storage는 공용 네트워크와 클러스터 네트워크 모두에 대해 통신 경로의 모든 네트워킹 장치에 걸쳐 동일한 MTU 값이 필요합니다. 프로덕션에서 Red Hat Ceph Storage 클러스터를 사용하기 전에 환경의 모든 호스트 및 네트워킹 장치에서 MTU 값이 동일한지 확인합니다.

2.2. Red Hat Ceph Storage의 기본 고려 사항

Red Hat Ceph Storage를 사용하는 첫 번째 고려 사항은 데이터를 위한 스토리지 전략을 개발하는 것입니다. 스토리지 전략은 특정 사용 사례에 서비스를 제공하는 데이터를 저장하는 방법입니다. OpenStack과 같은 클라우드 플랫폼에 대한 볼륨과 이미지를 저장해야 하는 경우 저널용 SSD(Solid State Drives)로 더 빠른 SAS( Serial Attached SCSI) 드라이브에 데이터를 저장하도록 선택할 수 있습니다. 반대로 S3 또는 Swift 호환 게이트웨이에 대한 오브젝트 데이터를 저장해야 하는 경우 기존 SATA(Serial Advanced Technology Attachment) 드라이브와 같이 더 경제적인 것을 사용할 수 있습니다. Red Hat Ceph Storage는 동일한 스토리지 클러스터에 있는 두 시나리오를 모두 수용할 수 있지만, 클라우드 플랫폼에 빠른 스토리지 전략을 제공하는 수단과 개체 저장소에 더 많은 기존 스토리지를 제공하는 수단이 필요합니다.

Ceph 배포의 가장 중요한 단계 중 하나는 스토리지 클러스터의 사용 사례와 워크로드에 적합한 가격대 성능 프로필을 식별하는 것입니다. 사용 사례에 적합한 하드웨어를 선택하는 것이 중요합니다. 예를 들어, 콜드 스토리지 애플리케이션에 최적화된 IOPS 하드웨어를 선택하면 하드웨어 비용이 불필요하게 증가합니다. 반면, IOPS 집약적인 워크로드에서 용량에 최적화된 하드웨어를 선택하는 경우 성능 저하에 대해 불만을 제기하는 사용자가 불만을 줄 수 있습니다.

Red Hat Ceph Storage는 여러 스토리지 전략을 지원할 수 있습니다. 사운드 스토리지 전략을 개발하는 데 도움이 되는 사용 사례, 비용 대비 성능 장단점 및 데이터 지속성이 가장 중요한 고려 사항입니다.

사용 사례

Ceph는 대용량 스토리지 용량을 제공하며 다음과 같은 다양한 사용 사례를 지원합니다.

- Ceph 블록 장치 클라이언트는 COW(Copy-On-Write 복제)와 같은 고성능 기능을 갖춘 볼륨 및 이미지에 대한 무제한 스토리지를 제공하는 클라우드 플랫폼용 최고의 스토리지 백엔드입니다.

- Ceph Object Gateway 클라이언트는 오디오, 비트맵, 비디오 및 기타 데이터와 같은 오브젝트에 RESTful S3 호환 및 Swift 호환 오브젝트 스토리지를 제공하는 클라우드 플랫폼의 선도적인 스토리지 백엔드입니다.

- 기존 파일 스토리지를 위한 Ceph 파일 시스템입니다.

비용 vs. 성능 이점

속도, 크기, 내구성 등이 더 우수합니다. 그러나 각 최상급 품질에는 각각 비용이 들기 때문에 비용 효율적인 측면에서 그에 상응하는 비용 대 편익 절충이 있다. 성능 관점에서 다음 사용 사례를 고려하십시오. SSD는 상대적으로 적은 양의 데이터와 저널링에 매우 빠른 스토리지를 제공할 수 있습니다. 데이터베이스 또는 개체 인덱스를 저장하면 매우 빠른 SSD 풀의 이점을 얻을 수 있지만 다른 데이터에 너무 많은 비용이 듭니다. SSD 저널링을 사용하는 SAS 드라이브는 볼륨과 이미지의 경제적인 가격으로 빠른 성능을 제공합니다. SSD 저널링이 없는 SATA 드라이브는 전체 성능이 낮은 저렴한 스토리지를 제공합니다. OSD의 RHEA 계층 구조를 생성할 때는 사용 사례와 성능 장단점에 비해 사용 가능한 비용을 고려해야 합니다.

데이터 내결함성

대규모 클러스터에서는 하드웨어 장애가 예상되며 예외는 아닙니다. 그러나 데이터 손실 및 서비스 중단은 허용되지 않습니다. 이러한 이유로 데이터 지속성이 매우 중요합니다. Ceph는 여러 오브젝트 복제본 사본 또는 삭제 코딩 및 여러 코딩 청크를 사용하여 데이터 지속성을 처리합니다. 여러 복사본 또는 여러 코딩 청크를 사용하면 추가 비용과 혜택의 장단점이 있습니다. 즉, 복사본 또는 코딩 청크를 더 적게 저장하는 것이 더 저렴하지만 성능 저하된 상태로 서비스 쓰기 요청을 사용할 수 없게 될 수 있습니다. 일반적으로 두 개의 추가 사본이 있는 하나의 오브젝트 또는 두 개의 코딩 청크를 사용하면 스토리지 클러스터를 복구하는 동안 성능이 저하된 상태로 스토리지 클러스터가 기록되도록 할 수 있습니다.

복제는 하드웨어 장애 발생 시 장애 도메인에서 데이터의 중복 복사본을 하나 이상 저장합니다. 그러나 데이터의 중복 복사본은 규모에 따라 비용이 많이 들 수 있습니다. 예를 들어, 3개 복제를 사용하여 1페타바이트의 데이터를 저장하려면 최소 3페타바이트 이상의 스토리지 용량이 있는 클러스터가 필요합니다.

코딩 삭제는 데이터를 데이터 청크 및 코딩 청크로 저장합니다. 데이터 청크가 손실되는 경우 삭제 코딩은 나머지 데이터 청크 및 코딩 청크를 사용하여 손실된 데이터 청크를 복구할 수 있습니다. 삭제 코딩은 복제보다 상당히 경제적입니다. 예를 들어 데이터 청크 8개와 코딩 청크 3개가 있는 삭제 코딩을 사용하면 데이터 복사본 3개와 동일한 중복성이 제공됩니다. 그러나 이러한 인코딩 체계는 복제와 3x와 비교하여 약 1.5x의 초기 데이터를 사용합니다.

CRUSH 알고리즘은 Ceph가 스토리지 클러스터 내의 다른 위치에 추가 사본 또는 코딩 청크를 저장할 수 있도록 하여 이 프로세스를 지원합니다. 이렇게 하면 단일 스토리지 장치 또는 호스트에 장애가 발생해도 데이터 손실을 방지하는 데 필요한 모든 복사 또는 코딩 청크가 손실되지 않습니다. 비용 대비 이점의 장단점이 있는 스토리지 전략을 계획하고 데이터 지속성을 염두에 두고 Ceph 클라이언트에 스토리지 풀로 제공할 수 있습니다.

데이터 스토리지 풀만 삭제 코딩을 사용할 수 있습니다. 서비스 데이터 및 버킷 인덱스를 저장하는 풀은 복제를 사용합니다.

Ceph의 개체 복사 또는 코딩 청크를 사용하면 RAID 솔루션이 더 이상 사용되지 않습니다. Ceph는 이미 데이터 지속성을 처리하므로 RAID를 사용하지 마십시오. 성능이 저하된 RAID는 성능에 부정적인 영향을 미치며 RAID를 사용하여 데이터를 복구하는 것은 깊은 복사본 또는 코딩 청크를 사용하는 것보다 훨씬 느립니다.

2.2.1. Ceph 데몬과 이점 비교

컨테이너화된 Ceph 데몬을 동일한 호스트에서 배치할 수 있습니다. 다음은 일부 Ceph 데몬을 배치하면 다음과 같은 이점이 있습니다.

- 소규모로 총소유비용(total cost of ownership)을 크게 개선합니다.

- 전체 성능을 향상시킬 수 있습니다.

- 최소 구성의 물리적 호스트 양을 줄입니다.

- 리소스 활용 개선.

- Red Hat Ceph Storage를 보다 쉽게 업그레이드할 수 있습니다.

컨테이너를 사용하면 다음 목록에서 하나의 데몬을 Ceph OSD 데몬(ceph-osd)과 함께 배치할 수 있습니다. 또한 Ceph Object Gateway(radosgw), Ceph 메타데이터 서버(ceph-mds) 및 Grafana의 경우 Ceph OSD 데몬과 아래 목록의 데몬과 함께 배치할 수 있습니다.

-

Ceph 메타 데이터 서버 (

ceph-mds) -

Ceph Monitor (

ceph-mon) -

Ceph Manager (

ceph-mgr) -

NFS Ganesha(

nfs-ganesha) -

Ceph Manager(

ceph-grafana)

| 호스트 이름 | 데몬 | 데몬 | 데몬 |

|---|---|---|---|

| host1 | OSD | 모니터링 및 관리자 | Prometheus |

| host2 | OSD | 모니터링 및 관리자 | RGW |

| host3 | OSD | 모니터링 및 관리자 | RGW |

| host4 | OSD | 메타 데이터 서버 | |

| host5 | OSD | 메타 데이터 서버 |

ceph-mon 및 ceph-mgr 은 공동 배치를 위해 두 개의 별도의 데몬으로 간주되지 않습니다.

Ceph 데몬을 ceph orch 명령에 --placement 옵션을 사용하여 명령행 인터페이스에서 배치하거나 서비스 사양 YAML 파일을 사용할 수 있습니다.

명령줄 예

[ceph: root@host01 /]# ceph orch apply mon --placement="host1 host2 host3"

[ceph: root@host01 /]# ceph orch apply mon --placement="host1 host2 host3"서비스 사양 YAML 파일 예

[ceph: root@host01 /]# ceph orch apply -i mon.yml

[ceph: root@host01 /]# ceph orch apply -i mon.ymlRed Hat은 Ceph Object Gateway를 Ceph OSD 컨테이너와 연결하여 성능을 향상시키는 것이 좋습니다. 추가 하드웨어 비용을 발생시키지 않고 최고 성능을 달성하려면 호스트당 두 개의 Ceph Object Gateway 데몬을 사용합니다.

Ceph Object Gateway 명령줄 예

[ceph: root@host01 /]# ceph orch apply rgw example --placement="6 host1 host2 host3"

[ceph: root@host01 /]# ceph orch apply rgw example --placement="6 host1 host2 host3"Ceph Object Gateway 서비스 사양 YAML 파일 예

[ceph: root@host01 /]# ceph orch apply -i rgw.yml

[ceph: root@host01 /]# ceph orch apply -i rgw.yml아래 다이어그램은 공동 배치 및 비할당 데몬이 있는 스토리지 클러스터의 차이점을 보여줍니다.

그림 2.1. 공동 배치된 데몬

그림 2.2. 공동배치되지 않은 데몬

2.3. Red Hat Ceph Storage 워크로드 고려 사항

Ceph 스토리지 클러스터의 주요 이점 중 하나는 성능 도메인을 사용하여 동일한 스토리지 클러스터 내에서 다양한 유형의 워크로드를 지원할 수 있다는 것입니다. 각 성능 도메인과 다른 하드웨어 구성을 연결할 수 있습니다. 스토리지 관리자는 적절한 성능 도메인에 스토리지 풀을 배포할 수 있으므로 애플리케이션에 특정 성능 및 비용 프로필에 맞는 스토리지를 제공할 수 있습니다. 이러한 성능 도메인에 맞게 크기가 조정되고 최적화된 서버를 선택하는 것은 Red Hat Ceph Storage 클러스터를 설계하는 데 있어 필수적인 부분입니다.

데이터를 읽고 쓰는 Ceph 클라이언트 인터페이스의 경우 Ceph 스토리지 클러스터는 클라이언트가 데이터를 저장하는 간단한 풀로 나타납니다. 그러나 스토리지 클러스터는 클라이언트 인터페이스에 완전히 투명한 방식으로 많은 복잡한 작업을 수행합니다. Ceph OSD라고 하는 Ceph 클라이언트 및 Ceph 개체 스토리지 데몬은 모두 오브젝트 스토리지 및 검색에 대해 CRUSH(Controlled Replication Under Scalable Hashing) 알고리즘을 사용합니다. Ceph OSD는 스토리지 클러스터 내의 컨테이너에서 실행할 수 있습니다.

CRUSH 맵은 클러스터 리소스의 토폴로지를 설명하고 이 맵은 클라이언트 호스트와 클러스터 내의 Ceph 모니터 호스트에 모두 존재합니다. Ceph 클라이언트 및 Ceph OSD는 모두 CRUSH 맵과 CRUSH 알고리즘을 사용합니다. Ceph 클라이언트는 OSD와 직접 통신하여 중앙 집중식 개체 조회 및 잠재적인 성능 병목 현상을 제거합니다. CRUSH 맵과 해당 피어의 통신을 인식하면 OSD에서 복제, 백필 및 복구 기능을 처리할 수 있으므로 동적 오류 복구를 수행할 수 있습니다.

Ceph는 CRUSH 맵을 사용하여 장애 도메인을 구현합니다. 또한 Ceph는 CRUSH 맵을 사용하여 성능 도메인을 구현합니다. 이 도메인은 단순히 기본 하드웨어의 성능 프로파일을 고려합니다. CRUSH 맵은 Ceph가 데이터를 저장하는 방법을 설명하고, 이는 단순한 계층 구조, 특히 재활용 그래프 및 규칙 세트로 구현됩니다. CRUSH 맵은 여러 계층 구조를 지원하여 한 가지 유형의 하드웨어 성능 프로필을 분리할 수 있습니다. Ceph는 장치 "클래스"로 성능 도메인을 구현합니다.

예를 들어 동일한 Red Hat Ceph Storage 클러스터에 이러한 성능 도메인을 공존할 수 있습니다.

- 하드 디스크 드라이브(HDD)는 일반적으로 비용 및 용량 중심 워크로드에 적합합니다.

- 처리량에 민감한 워크로드는 일반적으로 SSD(반도체 드라이브)에서 Ceph 쓰기 저널과 함께 HDD를 사용합니다.

- MySQL 및 MariaDB와 같은 IOPS 집약적 워크로드에서는 SSD를 자주 사용합니다.

그림 2.3. 성능 및 오류 도메인

워크로드

Red Hat Ceph Storage는 세 가지 주요 워크로드에 최적화되어 있습니다.

스토리지 클러스터의 가격 및 성능에 큰 영향을 미칠 수 있으므로 어떤 하드웨어를 구입할지 고려하기 전에 Red Hat Ceph Storage 클러스터에서 실행되는 워크로드를 신중하게 고려합니다. 예를 들어 워크로드가 용량에 최적화되고 처리량이 최적화된 워크로드에 하드웨어가 더 적합한 경우 하드웨어는 필요한 것보다 비용이 많이 듭니다. 반대로 워크로드가 처리량에 최적화되고 하드웨어가 용량이 최적화된 워크로드에 더 적합한 경우 스토리지 클러스터가 성능이 저하될 수 있습니다.

IOPS 최적화: 입력, 초당 출력(IOPS) 최적화 배포는 OpenStack에서 가상 시스템으로 MYSQL 또는 MariaDB 인스턴스를 실행하는 것과 같은 클라우드 컴퓨팅 작업에 적합합니다. IOPS 최적화된 배포에는 15k RPM SAS 드라이브와 같은 고성능 스토리지 및 자주 쓰기 작업을 처리하기 위해 별도의 SSD 저널이 필요합니다. 일부 IOPS 시나리오에서는 모든 Flash 스토리지를 사용하여 IOPS 및 총 처리량을 개선합니다.

IOPS가 최적화된 스토리지 클러스터에는 다음과 같은 속성이 있습니다.

- IOPS당 최소 비용.

- GB당 최대 IOPS.

- 99번째 백분위 대기 시간 일관성.

IOPS에 최적화된 스토리지 클러스터의 용도는 다음과 같습니다.

- 일반적인 블록 스토리지.

- 하드 드라이브(HDD)의 3x 복제 또는 솔리드 스테이트 드라이브(SSD)의 2x 복제.

- OpenStack 클라우드의 MySQL.

처리량 최적화: 처리량 최적화 배포는 그래픽, 오디오 및 비디오 콘텐츠와 같은 상당한 양의 데이터를 제공하는 데 적합합니다. 처리량에 최적화된 배포에는 높은 대역폭 네트워킹 하드웨어, 컨트롤러 및 하드 디스크 드라이브, 순차적 읽기 및 쓰기 기능이 필요합니다. 빠른 데이터 액세스가 요구 사항인 경우 처리량 최적화 스토리지 전략을 사용합니다. 또한 빠른 쓰기 성능이 필요한 경우 저널에 Solid State Disks (SSD)를 사용하면 쓰기 성능이 크게 향상됩니다.

처리량 최적화 스토리지 클러스터에는 다음과 같은 속성이 있습니다.

- MBps당 가장 낮은 비용(처리량)

- TB당 최대 MBps

- BTU당 최대 MBps

- Watt당 가장 높은 MBps

- 97%의 대기 시간 일관성

처리량 최적화 스토리지 클러스터에 대한 사용은 다음과 같습니다.

- 블록 또는 오브젝트 스토리지

- 3x 복제

- 비디오, 오디오 및 이미지를 위한 활성 성능 스토리지

- 4K 영상 등의 스트리밍 미디어

용량 최적화: 용량 최적화 배포는 상당한 양의 데이터를 가능한 한 저렴하게 저장하는 데 적합합니다. 용량 최적화 배포는 일반적으로 더 큰 가격대에 대한 성능을 거래합니다. 예를 들어 용량 최적화 배포에서는 저널링에 SSD를 사용하지 않고 속도가 느리고 비용이 적게 드는 SATA 드라이브를 사용하는 경우가 많습니다.

비용 및 용량 최적화 스토리지 클러스터에는 다음과 같은 속성이 있습니다.

- TB당 최소 비용

- TB당 최소 BTU 수

- TB당 필요한 최소 Watt

비용 및 용량 최적화 스토리지 클러스터에 대한 사용은 다음과 같습니다.

- 일반적으로 오브젝트 스토리지

- 사용 가능한 용량을 극대화하기 위한 지우기 코딩

- 오브젝트 아카이브

- 비디오, 오디오 및 이미지 오브젝트 리포지토리

2.4. Ceph Object Gateway 고려 사항

스토리지 클러스터를 설계할 때 고려해야 할 또 다른 중요한 측면은 스토리지 클러스터가 하나의 데이터 센터 사이트에 있는지 또는 여러 데이터 센터 사이트를 대상으로 하는지를 결정하는 것입니다. 다중 사이트 스토리지 클러스터는 장기적인 정전, 경사, 허리케인, 범람 또는 기타 재해와 같은 지리적으로 분산된 페일오버 및 재해 복구의 이점을 제공합니다. 또한 다중 사이트 스토리지 클러스터에는 클라이언트 애플리케이션을 사용 가능한 가장 가까운 스토리지 클러스터로 보낼 수 있는 활성 활성 구성이 있을 수 있습니다. 이는 콘텐츠 제공 네트워크에 적합한 스토리지 전략입니다. 데이터를 가능한 한 클라이언트에 가깝게 배치하는 것이 좋습니다. 이는 스트리밍 4k 비디오와 같은 처리량 집약적인 워크로드에 중요합니다.

Red Hat은 Ceph의 스토리지 풀을 생성하기 전에 영역, 영역 그룹 및 영역 이름을 식별하는 것이 좋습니다. 영역 이름을 표준 이름 지정 규칙으로 사용하는 일부 풀 이름 앞에 추가합니다.

2.4.1. 관리 데이터 스토리지

Ceph Object Gateway는 인스턴스의 영역 구성에 정의된 일련의 풀에 관리 데이터를 저장합니다. 예를 들어 후속 섹션에서 설명하는 버킷, 사용자, 사용자 할당량 및 사용량 통계는 Ceph 스토리지 클러스터의 풀에 저장됩니다. 기본적으로 Ceph Object Gateway는 다음 풀을 생성하여 기본 영역에 매핑합니다.

-

.rgw.root -

.default.rgw.control -

.default.rgw.meta -

.default.rgw.log -

.default.rgw.buckets.index -

.default.rgw.buckets.data -

.default.rgw.buckets.non-ec

.default.rgw.buckets.index 풀은 Ceph Object Gateway에서 버킷이 생성된 후에만 생성되는 반면 .default.rgw.buckets.data 풀은 버킷에 업로드된 후 생성됩니다.

CRUSH 규칙 세트와 배치 그룹 수를 설정할 수 있도록 이러한 풀을 수동으로 생성하는 것이 좋습니다. 일반적인 구성에서 Ceph Object Gateway의 관리 데이터를 저장하는 풀은 종종 동일한 CRUSH 규칙 세트를 사용하고 관리 데이터에 10개의 풀이 있으므로 배치 그룹을 더 적게 사용합니다.

Red Hat은 .rgw.root 풀과 서비스 풀이 동일한 CRUSH 계층 구조를 사용하고 CRUSH 규칙에서 실패 도메인으로 노드를 사용하는 것이 좋습니다. Red Hat은 데이터 지속성을 위해 복제 를 사용하는 것이 좋습니다. .rgw.root 풀 및 서비스 풀에는 삭제되지 않는 것이 좋습니다.

mon_pg_warn_max_per_osd 설정은 기본적으로 풀에 너무 많은 배치 그룹을 할당하는 경우 경고합니다. 요구 사항과 하드웨어의 기능에 맞게 값을 조정할 수 있습니다. 여기서 n 은 OSD당 최대 PG 수입니다.

mon_pg_warn_max_per_osd = n

mon_pg_warn_max_per_osd = n

.rgw.root 를 포함한 서비스 풀의 경우 풀 계산기당 Ceph 배치 그룹(PG)의 권장 PG 수는 Ceph OSD당 대상 PG보다 훨씬 적습니다. 또한 계산기 4단계에서 Ceph OSD의 수가 설정되어 있는지 확인합니다.

가비지 컬렉션은 OMAP 대신 일반 RADOS 개체와 함께 .log 풀을 사용합니다. 향후 릴리스에서는 더 많은 기능이 .log 풀에 메타데이터를 저장합니다. 따라서 Red Hat은 .log 풀에 NVMe/SSD Ceph OSD를 사용하는 것이 좋습니다.

.rgw.root 풀

Ceph Object Gateway 구성이 저장된 풀입니다. 여기에는 영역, 영역 그룹 및 영역이 포함됩니다. 규칙에 따라 해당 이름이 영역 이름 앞에 추가되지 않습니다.

서비스 풀

서비스 풀은 서비스 제어, 가비지 수집, 로깅, 사용자 정보 및 사용과 관련된 오브젝트를 저장합니다. 규칙에 따라 이러한 풀 이름에는 풀 이름 앞에 영역 이름이 있습니다.

-

.ZONE_NAME.rgw.control: 제어 풀입니다. -

.ZONE_NAME.log: 로그 풀에는 create, read, update, delete와 같은 모든 버킷, 컨테이너 및 오브젝트 작업의 로그가 포함됩니다. -

.ZONE_NAME.rgw.buckets.index: 이 풀은 버킷의 인덱스를 저장합니다. -

.ZONE_NAME.rgw.buckets.data:이 풀은 버킷의 데이터를 저장합니다. -

.ZONE_NAME.rgw.meta: 메타데이터 풀은 user_keys 및 기타 중요한 메타데이터를 저장합니다. -

.ZONE_NAME.meta:users.uid: 사용자 ID 풀에는 고유한 사용자 ID 맵이 포함되어 있습니다. -

.ZONE_NAME.meta:users.keys: 키 풀에는 각 사용자 ID에 대한 액세스 키와 시크릿 키가 포함되어 있습니다. -

.ZONE_NAME.meta:users.email: 이메일 풀에는 사용자 ID와 연결된 이메일 주소가 포함되어 있습니다. -

.ZONE_NAME.meta:users.swift: Swift 풀에는 사용자 ID에 대한 Swift 하위 사용자 정보가 포함되어 있습니다.

2.4.2. 인덱스 풀

Ceph Object Gateway와 함께 사용할 OSD 하드웨어를 선택하는 경우 인덱스 풀을 저장하기 위해 SSD 또는 NVMe 드라이브 중 하나 이상의 고성능 드라이브가 있는 OSD 노드를 사용할 수 있습니다. 이는 버킷에 많은 오브젝트가 포함된 경우 특히 중요합니다.

Bluestore를 실행하는 Red Hat Ceph Storage의 경우 별도의 풀이 아닌 NVMe 드라이브를 block.db 장치로 배포하는 것이 좋습니다.

Ceph Object Gateway 인덱스 데이터는 개체 맵(OMAP)에만 작성됩니다. BlueStore의 OMAP 데이터는 OSD의 block.db 장치에 있습니다. NVMe 드라이브가 HDD OSD의 block.db 장치로 작동하고 인덱스 풀이 HDD OSD에서 지원되면 인덱스 데이터는 block.db 장치에만 기록됩니다. block.db partition/lvm이 블록의 4%에 올바르게 크기가 조정되는 한, 이 구성은 BlueStore에 필요한 모든 것입니다.

Red Hat은 인덱스 풀에 대한 HDD 장치를 지원하지 않습니다. 지원되는 구성에 대한 자세한 내용은 Red Hat Ceph Storage: 지원되는 구성 문서를 참조하십시오.

인덱스 항목은 약 200바이트의 데이터이며, rocksdb 에서 OMAP로 저장됩니다. 이는 간단한 양의 데이터이지만 Ceph Object Gateway를 사용하면 수십 또는 수백 만 개의 개체가 단일 버킷에 포함될 수 있습니다. 인덱스 풀을 고성능 스토리지 미디어의 CRUSH 계층 구조에 매핑함으로써 버킷에 많은 오브젝트가 포함된 경우 대기 시간이 크게 단축됩니다.

프로덕션 클러스터에서 일반적인 OSD 노드에는 OSD 저널과 동일한 물리 드라이브에 별도의 파티션 또는 논리 볼륨을 사용하는 인덱스 풀 또는 block.db 장치를 저장하기 위한 최소 하나의 SSD 또는 NVMe 드라이브가 있습니다.

2.4.3. 데이터 풀

데이터 풀은 Ceph Object Gateway가 특정 스토리지 정책에 대한 오브젝트 데이터를 저장하는 위치입니다. 데이터 풀은 서비스 풀의 PG 수를 줄이는 대신 PG(배포 그룹)를 완전히 보완합니다. 복제보다 훨씬 효율적이므로 데이터 풀에 삭제 코딩을 사용하는 것이 중요하며 데이터 지속성을 유지하면서 용량 요구 사항을 크게 줄일 수 있습니다.

삭제 코딩을 사용하려면 삭제 코드 프로필을 생성합니다. 자세한 내용은 Red Hat Ceph Storage Storage Strategies Guide 의 Erasure Code Profiles 섹션을 참조하십시오.

풀을 생성한 후에는 프로필을 변경할 수 없으므로 올바른 프로필을 선택하는 것이 중요합니다. 프로필을 수정하려면 다른 프로필을 사용하여 새 풀을 생성하고 이전 풀에서 새 풀로 오브젝트를 마이그레이션해야 합니다.

기본 구성은 두 개의 데이터 청크와 하나의 인코딩 청크로, 하나의 OSD만 손실될 수 있습니다. 복원력이 높은 경우 더 많은 수의 데이터 및 인코딩 청크를 고려하십시오. 예를 들어 일부 대규모 시스템은 8개의 데이터 청크와 3 인코딩 청크를 사용하므로 데이터 손실 없이 3개의 OSD가 실패할 수 있습니다.

각 데이터 및 인코딩 청크는 최소한 다른 노드나 호스트에 저장됩니다. 소규모 스토리지 클러스터의 경우 더 많은 수의 데이터 및 인코딩 청크에 대해 최소 CRUSH 장애 도메인으로 rack 을 사용할 수 없습니다. 따라서 데이터 풀은 일반적으로 host와 함께 별도의 CRUSH 계층 구조를 최소 CRUSH 장애 도메인으로 사용하는 것이 일반적입니다. Red Hat은 최소 장애 도메인으로 host를 권장합니다. 코드 청크 삭제가 동일한 호스트 내의 Ceph OSD에 저장되는 경우 실패한 저널 또는 네트워크 카드와 같은 호스트 실패로 인해 데이터가 손실될 수 있습니다.

데이터 풀을 생성하려면 풀 이름, PG 및 PGP의 수, 삭제 데이터 지속성 방법, 삭제 코드 프로필, 규칙 이름을 사용하여 ceph osd pool create 명령을 실행합니다.

2.4.4. 데이터 추가 풀

data_extra_pool 은 삭제 코딩을 사용할 수 없는 데이터를 위한 것입니다. 예를 들어 다중 파트 업로드를 사용하면 여러 부분의 동영상과 같은 큰 오브젝트를 업로드할 수 있습니다. 이 부분은 삭제 코딩 없이 먼저 저장해야 합니다. 삭제 코딩은 부분적인 업로드가 아닌 전체 오브젝트에 적용됩니다.

풀 계산기당 PG(배치 그룹)는 data_extra_pool 에 대한 풀당 PG 수를 더 적게 권장합니다. 그러나 PG 수는 서비스 풀과 동일한 PG 수이고 버킷 인덱스 풀과 동일합니다.

데이터 추가 풀을 생성하려면 풀 이름, PG 및 PGP 수, 복제된 데이터 지속성 방법 및 규칙 이름을 사용하여 ceph osd pool create 명령을 실행합니다. 예를 들면 다음과 같습니다.

ceph osd pool create .us-west.rgw.buckets.non-ec 64 64 replicated rgw-service

# ceph osd pool create .us-west.rgw.buckets.non-ec 64 64 replicated rgw-service2.5. CRUSH 계층 구조 개발

스토리지 관리자는 Ceph 스토리지 클러스터 및 오브젝트 게이트웨이를 배포할 때 일반적으로 Ceph Object Gateway에는 기본 영역 그룹과 영역이 있습니다. Ceph 스토리지 클러스터에는 기본 풀이 있으므로 기본 CRUSH 계층 구조와 함께 CRUSH 맵과 기본 CRUSH 규칙이 사용됩니다.

기본 rbd 풀은 기본 CRUSH 규칙을 사용할 수 있습니다. Ceph 클라이언트가 클라이언트 데이터를 저장하는 데 기본 규칙 또는 계층을 삭제하지 마십시오.

프로덕션 게이트웨이는 일반적으로 게이트웨이의 사용 및 지리적 위치에 따라 이름이 지정된 사용자 지정 영역, 영역 그룹 및 영역을 사용합니다. 또한 Ceph 스토리지 클러스터에는 CRUSH 계층 구조가 여러 개의 CRUSH 맵이 있습니다.

-

서비스 풀: 하나 이상의 CRUSH 계층 구조는 서비스 풀 및 잠재적으로 데이터를 위한 것입니다. 서비스 풀에는

.rgw.root및 영역과 연결된 서비스 풀이 포함됩니다. 서비스 풀은 일반적으로 단일 CRUSH 계층 구조에 속하며 데이터 지속성에 복제를 사용합니다. 데이터 풀은 CRUSH 계층 구조를 사용할 수도 있지만, 일반적으로 이 풀은 데이터 지속성을 위해 삭제 코딩으로 구성됩니다. - 인덱스: CRUSH 계층 구조 SHOULD 는 CRUSH 계층 구조가 SSD 또는 NVMe 드라이브와 같은 고성능 미디어에 매핑되는 인덱스 풀에 사용됩니다. 버킷 인덱스는 성능 장애일 수 있습니다. Red Hat은 이 CRUSH 계층 구조에서 SSD 또는 NVMe 드라이브를 사용하는 것이 좋습니다. Ceph OSD 저널에 사용되는 SSD 또는 NVMe 드라이브에서 인덱스의 파티션을 생성합니다. 또한 인덱스는 버킷 분할을 사용하여 구성해야 합니다.

- 배치 풀: 각 배치 대상의 배치 풀에는 버킷 인덱스, 데이터 버킷, 버킷 추가 기능이 포함됩니다. 이러한 풀은 별도의 CRUSH 계층 구조에 속할 수 있습니다. Ceph Object Gateway는 여러 스토리지 정책을 지원할 수 있으므로 스토리지 정책의 버킷 풀은 IOPS에 최적화된 IOPS, 처리량 최적화 및 용량 최적화와 같은 다양한 사용 사례를 반영하여 다양한 CRUSH 계층 구조와 연관될 수 있습니다. 버킷 인덱스 풀 SHOULD 는 자체 CRUSH 계층 구조를 사용하여 버킷 인덱스 풀을 SSD 또는 NVMe 드라이브와 같은 고성능 스토리지 미디어에 매핑합니다.

2.5.1. CRUSH 루트 생성

관리 노드의 명령줄에서 각 CRUSH 계층 구조에 대한 CRUSH 맵에 CRUSH 루트를 생성합니다. 데이터 스토리지 풀을 잠재적으로 제공할 수 있는 서비스 풀에는 CRUSH 계층 구조가 하나 이상 있어야 합니다. SSD 또는 NVMe 드라이브와 같은 고성능 스토리지 미디어에 매핑되는 버킷 인덱스 풀에 대한 CRUSH 계층 구조가 하나 이상 있어야 합니다.

CRUSH 계층 구조에 대한 자세한 내용은 Red Hat Ceph Storage Storage Strategies Guide 7 의 CRUSH 계층 구조 섹션을 참조하십시오.

CRUSH 맵을 수동으로 편집하려면 Red Hat Ceph Storage Storage Strategies Guide 7 의 CRUSH 맵 편집 섹션을 참조하십시오.

다음 예제에서 data0, 및 data 1data2 라는 호스트는 동일한 물리적 호스트를 가리키는 여러 CRUSH 계층 구조가 있으므로 data0-sas-ssd,data0-index 등의 확장된 논리 이름을 사용합니다.

일반적인 CRUSH 루트는 저널의 SAS 드라이브 및 SSD로 노드를 나타낼 수 있습니다. 예를 들면 다음과 같습니다.

버킷 인덱스의 CRUSH 루트 는 SSD 또는 NVMe 드라이브와 같은 고성능 미디어를 나타냅니다. OSD 저널을 저장하는 SSD 또는 NVMe 미디어에 파티션을 생성하는 것이 좋습니다. 예를 들면 다음과 같습니다.

2.5.2. CRUSH 맵에서 논리 호스트 이름 사용

RHCS 3 이상 릴리스에서 CRUSH는 RHCS 2 및 이전 릴리스에서 지원되지 않는 스토리지 장치 "클래스"의 개념을 지원합니다. NVMe, SSD 또는 HDD와 같이 여러 스토리지 장치가 포함된 호스트 또는 노드가 있는 RHCS 3 클러스터에서는 장치 클래스가 있는 단일 CRUSH 계층 구조를 사용하여 스토리지 장치의 클래스를 구분합니다. 이렇게 하면 논리 호스트 이름을 사용할 필요가 없습니다. RHCS 2 및 이전 릴리스에서는 각 장치 클래스에 대해 여러 CRUSH 계층 구조 및 논리 호스트 이름을 사용하여 CRUSH 계층 구조의 호스트 또는 노드를 구분합니다.

RHCS 3 이상 릴리스에서 CRUSH는 RHCS 2 및 이전 릴리스에서 지원되지 않는 스토리지 장치 "class"의 개념을 지원합니다. NVMe, SSD 또는 HDD와 같이 스토리지 장치의 여러 클래스가 포함된 호스트 또는 노드가 있는 RHCS 3 클러스터에서는 장치 클래스와 함께 단일 CRUSH 계층 구조를 사용하여 스토리지 장치의 다른 클래스를 구분합니다. 이렇게 하면 논리 호스트 이름을 사용할 필요가 없습니다. RHCS 2 및 이전 릴리스에서는 각 장치 클래스에 대해 여러 CRUSH 계층 구조 및 논리 호스트 이름을 사용하여 CRUSH 계층 구조의 호스트 또는 노드를 구분합니다.

CRUSH 맵에서 호스트 이름은 고유해야 하며 한 번만 사용해야 합니다. 호스트가 여러 CRUSH 계층 구조 및 사용 사례를 제공하는 경우 CRUSH 맵은 실제 호스트 이름이 한 번만 사용되는지 확인하기 위해 논리 호스트 이름을 사용할 수 있습니다. 예를 들어 노드에는 SSD, SSD 저널이 있는 SAS 드라이브, 공동 배치된 저널이 있는 SATA 드라이브와 같은 여러 개의 드라이브 클래스가 있을 수 있습니다. RHCS 2 및 이전 릴리스에서 동일한 호스트에 대해 여러 CRUSH 계층 구조를 생성하려면 계층에서 실제 호스트 이름 대신 논리 호스트 이름을 사용해야 버킷 이름이 CRUSH 계층 구조 내에서 고유합니다. 예를 들어 호스트 이름이 data2 인 경우 CRUSH 계층 구조에서 data2-sas-ssd 및 data2-index 와 같은 논리 이름을 사용할 수 있습니다.

앞서 언급한 예에서 호스트 data2 는 논리 이름 data2-sas-ssd 를 사용하여 SSD의 저널이 있는 SAS 드라이브를 하나의 계층 구조로 매핑합니다. osd.0 부터 osd.3 까지 OSD ID는 높은 처리량 하드웨어 구성에서 SSD 저널을 사용하는 SAS 드라이브를 나타냅니다. 이러한 OSD ID는 다음 예의 OSD ID와 다릅니다.

다음 예에서 호스트 data2 는 논리 이름 data2-index 를 사용하여 버킷 인덱스의 SSD 드라이브를 두 번째 계층 구조에 매핑합니다. OSD ID osd.4 는 버킷 인덱스 풀에 독점적으로 사용되는 SSD 드라이브 또는 기타 고속 스토리지 미디어를 나타냅니다.

논리 호스트 이름을 사용하는 경우 OSD 시작 스크립트가 시작 시 실제 호스트 이름을 사용하지 못하도록 다음 설정 중 하나가 Ceph 구성 파일에 있는지 확인합니다. 따라서 CRUSH 맵에서 데이터를 찾지 못합니다.

CRUSH 맵에서 앞의 예와 같이 논리 호스트 이름을 사용하는 경우 OSD 시작 스크립트가 초기화 시 실제 호스트 이름에 따라 호스트를 식별하지 못하도록 합니다. Ceph 구성 파일의 [global] 섹션에 다음 설정을 추가합니다.

osd_crush_update_on_start = false

osd_crush_update_on_start = false

논리적 호스트 이름을 정의하는 또 다른 방법은 Ceph 구성 파일의 [osd.<ID>] 섹션에 있는 각 OSD에 대한 CRUSH 맵의 위치를 정의하는 것입니다. OSD 시작 스크립트에서 정의하는 모든 위치를 재정의합니다. 앞서 언급한 예제에서 항목은 다음과 같을 수 있습니다.

CRUSH 맵이 실제 호스트 이름이 아닌 논리 호스트 이름을 사용할 때 예상 방법 중 하나를 사용하지 않는 경우 Ceph Storage Cluster는 OSD가 실제 호스트 이름에 매핑된다고 가정하고, Ceph Storage Cluster는 CRUSH 맵에서 실제 호스트 이름을 찾을 수 없으며 Ceph Storage 클러스터 클라이언트는 OSD와 해당 데이터를 찾을 수 없습니다.

2.5.3. CRUSH 규칙 생성

기본 CRUSH 계층 구조와 마찬가지로 CRUSH 맵에는 기본 CRUSH 규칙도 포함되어 있습니다.

기본 rbd 풀에서 이 규칙을 사용할 수 있습니다. 다른 풀에서 고객 데이터를 저장하는 데 기본 규칙을 삭제하지 마십시오.

CRUSH 규칙에 대한 자세한 내용은 Red Hat Ceph Storage 7용 Red Hat Ceph Storage Strategies Guide 의 CRUSH 규칙 섹션을 참조하십시오. CRUSH 맵을 수동으로 편집하려면 Red Hat Ceph Storage 7용 Red Hat Ceph Storage Storage Strategies Guide 의 CRUSH 맵 편집 섹션을 참조하십시오.

각 CRUSH 계층 구조에 대해 CRUSH 규칙을 생성합니다. 다음 예제에서는 .rgw.root 를 포함하여 서비스 풀을 저장할 CRUSH 계층 구조의 규칙을 보여줍니다. 이 예제에서 루트 sas-ssd 는 기본 CRUSH 계층 구조로 사용됩니다. 이름 rgw-service 를 사용하여 기본 규칙과 구분합니다. step take sas-ssd line은 CRUSH 루트 생성 에서 생성된 sas-ssd 루트를 사용하도록 풀에 지시합니다. 여기서 하위 버킷에는 SAS 드라이브가 포함된 OSD 및 높은 처리량 하드웨어 구성 저널에 대해 SSD 또는 NVMe 드라이브와 같은 고성능 스토리지 미디어가 포함됩니다. 단계 chooseleaf 의 유형 랙 부분은 실패 도메인입니다. 다음 예제에서는 랙입니다.

위 예제에서 데이터가 세 번 복제되는 경우 클러스터에 비슷한 개수의 OSD 노드를 포함하는 랙이 3개 이상 있어야 합니다.

복제된 설정 유형은 데이터 지속성, 복제본 수 또는 삭제 코딩과 관련이 없습니다. 복제 만 지원됩니다.

다음 예제에서는 데이터 풀을 저장할 CRUSH 계층 구조의 규칙을 보여줍니다. 이 예에서 루트 sass d 는 기본 CRUSH 계층 구조로 사용됩니다. 서비스 규칙과 동일한 CRUSH 계층 구조입니다. rgw-throughput 을 사용하여 기본 규칙과 rgw-service 를 구분합니다. step take sas-ssd line은 CRUSH 루트 생성 에서 생성된 sas-ssd 루트를 사용하도록 풀에 지시합니다. 여기서 하위 버킷에는 SAS 드라이브가 포함된 OSD 및 높은 처리량 하드웨어 구성에서 SSD 또는 NVMe 드라이브와 같은 고성능 스토리지 미디어가 포함됩니다. 단계 chooseleaf 의 유형 호스트 부분은 실패 도메인입니다. 다음 예제에서는 호스트입니다. 규칙은 동일한 CRUSH 계층 구조이지만 다른 오류 도메인을 사용합니다.

위 예에서 풀이 기본값보다 많은 수의 데이터 및 인코딩 청크를 사용하여 삭제 코딩을 사용하는 경우 클러스터에 유사한 수의 OSD 노드가 포함된 랙이 있어야 삭제 코딩 청크를 용이하게 합니다. 소규모 클러스터의 경우 이는 실용적이지 않을 수 있으므로 위 예제는 host 를 CRUSH 장애 도메인으로 사용합니다.

다음 예제에서는 인덱스 풀을 저장할 CRUSH 계층 구조의 규칙을 보여줍니다. 이 예에서 루트 인덱스 는 기본 CRUSH 계층 구조 역할을 합니다. rgw-index 를 사용하여 rgw-service 및 rgw-throughput 과 구별합니다. step take index 행은 CRUSH 루트 생성 에서 생성된 인덱스 루트를 사용하도록 지시합니다. 하위 버킷에는 SSD 또는 NVMe 드라이브와 같은 고성능 스토리지 미디어 또는 OSD 저널도 저장하는 SSD 또는 NVMe 드라이브의 파티션이 포함되어 있습니다. 단계 chooseleaf 의 유형 랙 부분은 실패 도메인입니다. 다음 예제에서는 랙입니다.

2.6. Ceph Object Gateway 다중 사이트 고려 사항

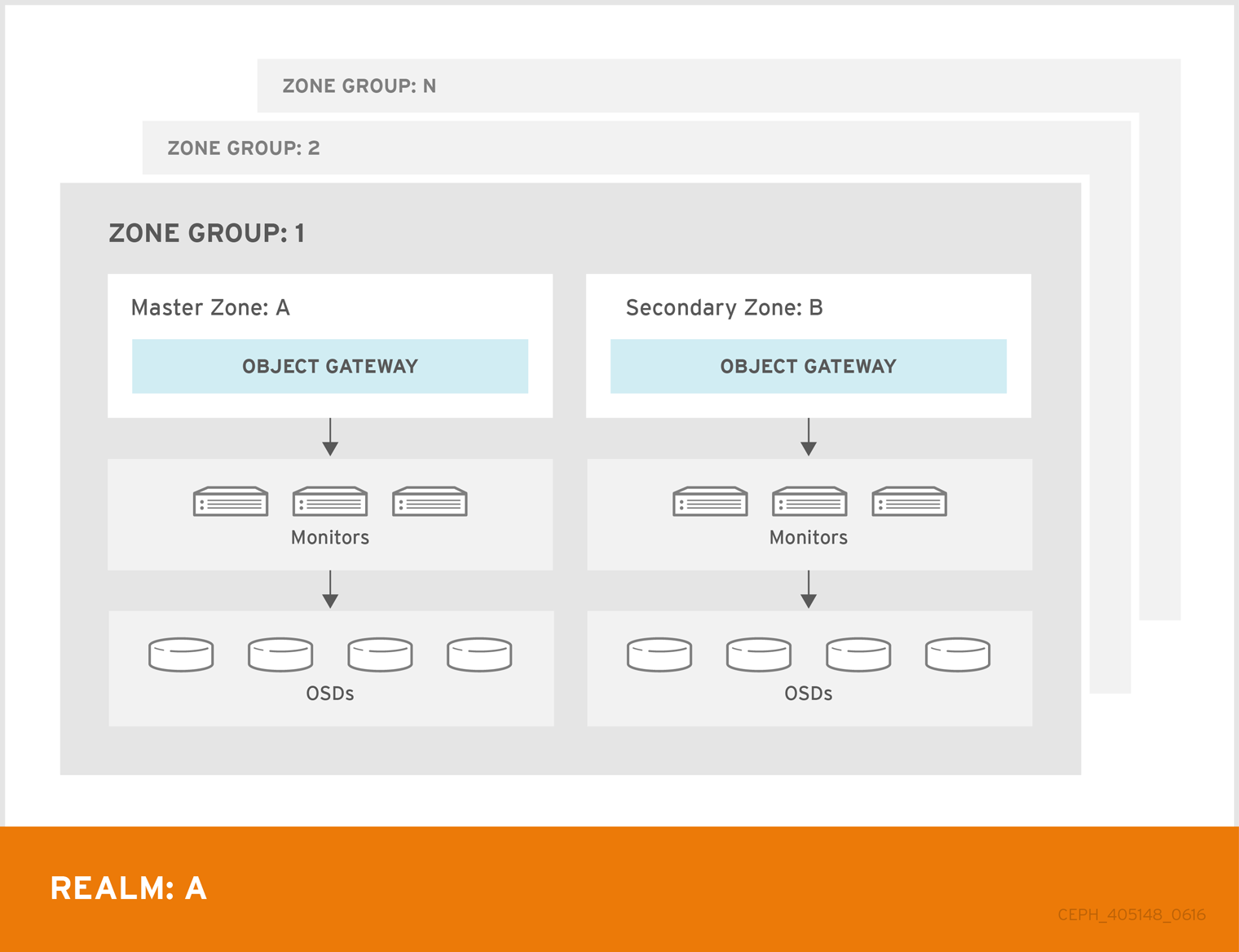

Ceph Object Gateway 다중 사이트 구성에는 두 개 이상의 Red Hat Ceph Storage 클러스터와 Ceph Object Gateway 인스턴스가 각각 하나씩 필요합니다. 일반적으로 두 개의 Red Hat Ceph Storage 클러스터는 지리적으로 별도의 위치에 있지만 이와 동일한 다중 사이트 구성은 동일한 물리적 사이트에 있는 두 개의 Red Hat Ceph Storage 클러스터에서 작동할 수 있습니다.

다중 사이트 구성에는 기본 영역 그룹과 기본 영역이 필요합니다. 또한 각 영역 그룹에는 기본 영역이 필요합니다. 영역 그룹에는 하나 이상의 보조 영역이 있을 수 있습니다.

CLI 또는 Red Hat Ceph Storage 대시보드를 통해 다중 사이트를 구성할 수 있습니다. 자세한 내용은 Ceph 대시보드에서 다중 사이트 오브젝트 게이트웨이 구성 을 참조하십시오.

영역의 기본 영역 그룹 내의 기본 영역은 사용자, 할당량 및 버킷을 포함하여 영역 메타데이터의 기본 복사본을 저장합니다. 이 메타데이터는 보조 영역 및 보조 영역 그룹과 자동으로 동기화됩니다. radosgw-admin CLI(명령줄 인터페이스)에서 발행된 메타데이터 작업은 기본 영역 그룹의 기본 영역 내의 노드에서 실행되어야 보조 영역 그룹 및 영역에 동기화되도록 해야 합니다. 현재 보조 영역 및 영역 그룹에서 메타데이터 작업을 실행할 수 있지만 동기화 되지 않아 메타데이터의 조각화가 발생할 수 있으므로 권장되지 않습니다.

아래 다이어그램은 다중 사이트 Ceph Object Gateway 환경에서 가능한 하나와 두 개의 영역 구성을 보여줍니다.

그림 2.4. 1개의 Cryostat

그림 2.5. 두 개의 Cryostat

그림 2.6. 두 개의 Variant

2.7. 스토리지 크기 조정 고려

클러스터 설계에서 가장 중요한 요소 중 하나는 스토리지 요구 사항(크기)을 결정하는 것입니다. Ceph 스토리지는 페타바이트 이상으로 확장되도록 설계되었습니다. 다음 예제는 Ceph 스토리지 클러스터의 일반적인 크기입니다.

- 소규모: 250 테라바이트

- 중간: 1 페타바이트

- Large: 2 페타바이트 이상

현재 요구 사항과 가까운 미래의 요구 사항이 포함됩니다. 게이트웨이 클라이언트가 클러스터에 새 데이터를 추가할 속도를 고려합니다. 사용 사례와 다를 수 있습니다. 예를 들어, 4k 동영상 기록 또는 의료 이미지 저장은 금융 시장 데이터와 같이 저장 집약적인 정보보다 상당한 양의 데이터를 더 빠르게 추가할 수 있습니다. 또한 복제 및 삭제 코딩과 같은 데이터 지속성 방법은 필요한 스토리지 미디어에 상당한 영향을 미칠 수 있습니다.

크기 조정에 대한 자세한 내용은 OSD 하드웨어를 선택하기 위한 Red Hat Ceph Storage 하드웨어 가이드 및 관련 링크를 참조하십시오.

2.8. 스토리지 밀도 고려

Ceph 설계의 또 다른 중요한 측면은 스토리지 밀도를 포함합니다. 일반적으로 스토리지 클러스터는 최소 10개의 노드에 걸쳐 데이터를 저장하여 복제, 백필 및 복구 시 적절한 성능을 보장합니다. 스토리지 클러스터에 노드가 10개 이상인 노드에 오류가 있는 경우 데이터의 10%만 남아 있는 노드로 이동해야 합니다. 노드 수가 크게 적으면 데이터의 백분율이 남아 있는 노드로 이동해야 합니다. 또한, 스토리지 클러스터가 데이터를 쓸 수 있도록 노드 실패를 수용하려면 full_ratio 및 near_full_ratio 옵션을 설정해야 합니다. 따라서 스토리지 밀도를 고려해야 합니다. 높은 스토리지 밀도가 반드시 좋은 것은 아닙니다.

스토리지 밀도가 높은 더 많은 노드를 선호하는 또 다른 요소는 삭제 코딩입니다. 삭제 코딩을 사용하여 오브젝트를 작성하고 노드를 최소 CRUSH 장애 도메인으로 사용할 때 Ceph 스토리지 클러스터에는 데이터 및 코딩 청크만큼 많은 노드가 필요합니다. 예를 들어 k=8 을 사용하는 클러스터에는 각 데이터 또는 코딩 청크가 별도의 노드에 저장되도록 k=8개 이상의 노드가 11개 이상 있어야 합니다.

핫스케이핑도 중요한 고려 사항입니다. 대부분의 최신 서버는 드라이브 핫스케이핑을 지원합니다. 그러나 일부 하드웨어 구성에서는 드라이브를 교체하려면 두 개 이상의 드라이브를 제거해야 합니다. Red Hat은 실패한 디스크를 스와핑할 때 필요한 것보다 더 많은 Ceph OSD를 가져올 수 있으므로 이러한 구성을 방지하는 것이 좋습니다.

2.9. Ceph Monitor 노드의 디스크 고려

Ceph Monitor는 rocksdb 를 사용하며 이는 동기 쓰기 대기 시간에 민감합니다. Red Hat은 Ceph Monitor 데이터를 저장하기 위해 SSD 디스크를 사용하는 것이 좋습니다. 순차적 쓰기 및 처리량 특성이 충분한 SSD 디스크를 선택합니다.

2.10. 백필 및 복구 설정 조정

I/O는 백필링 및 복구 작업 둘 다에 부정적인 영향을 미치므로 성능이 저하되고 최종 사용자가 불만족합니다. 클러스터 확장 또는 복구 중에 I/O 수요를 수용하려면 Ceph 구성 파일에서 다음 옵션과 값을 설정합니다.

[osd] osd_max_backfills = 1 osd_recovery_max_active = 1 osd_recovery_op_priority = 1

[osd]

osd_max_backfills = 1

osd_recovery_max_active = 1

osd_recovery_op_priority = 12.11. 클러스터 맵 크기 조정

기본적으로 ceph-osd 데몬은 500 이전 osdmaps를 캐시합니다. 중복 제거에도 불구하고 맵은 데몬당 많은 메모리를 사용할 수 있습니다. Ceph 구성에서 캐시 크기를 조정하면 메모리 사용량을 크게 줄일 수 있습니다. 예를 들면 다음과 같습니다.

[ceph: root@host01 /]# ceph config set global osd_map_message_max 10 [ceph: root@host01 /]# ceph config set osd osd_map_cache_size 20 [ceph: root@host01 /]# ceph config set osd osd_map_share_max_epochs 10 [ceph: root@host01 /]# ceph config set osd osd_pg_epoch_persisted_max_stale 10

[ceph: root@host01 /]# ceph config set global osd_map_message_max 10

[ceph: root@host01 /]# ceph config set osd osd_map_cache_size 20

[ceph: root@host01 /]# ceph config set osd osd_map_share_max_epochs 10

[ceph: root@host01 /]# ceph config set osd osd_pg_epoch_persisted_max_stale 10

Red Hat Ceph Storage 버전 3 이상의 경우 ceph-manager 데몬이 PG 쿼리를 처리하므로 클러스터 맵은 성능에 영향을 미치지 않아야 합니다.

2.12. 스크럽 조정

기본적으로 Ceph는 매주 간단한 스크럽과 깊은 스크럽을 수행합니다. Light scrubbing은 오브젝트 크기와 체크섬을 확인하여 PG가 동일한 오브젝트 데이터를 저장하고 있는지 확인합니다. 시간이 지남에 따라 디스크 섹터는 오브젝트 크기 및 체크섬에 관계없이 잘못된 상태가 될 수 있습니다. 딥 스크러빙은 실제 콘텐츠가 동일한지 확인하기 위해 해당 복제본과 함께 오브젝트의 콘텐츠를 확인합니다. 이와 관련하여 딥러빙은 fsck 방식으로 데이터 무결성을 보장하지만 절차는 클러스터에 I/O 페널티를 부과합니다. 간단한 스크러빙도 I/O에 영향을 미칠 수 있습니다.

기본 설정을 사용하면 Ceph OSD에서 최대 작동 시간 또는 로드가 많은 기간과 같은 inopportune 시간에 스크럽을 시작할 수 있습니다. 최종 사용자는 작업이 최종 사용자 작업과 충돌할 때 대기 시간 및 성능이 저하될 수 있습니다.

최종 사용자가 성능이 저하되는 것을 방지하기 위해 Ceph는 더 낮은 로드를 사용하거나 사용량이 적은 기간으로 스크럽을 제한할 수 있는 여러 가지 스크럽 설정을 제공합니다. 자세한 내용은 Red Hat Ceph Storage 구성 가이드의 OSD Scrubbing the OSD 섹션을 참조하십시오.

클러스터에서 낮에 높은 로드가 발생하고 야간에 지연 시간이 짧은 경우 야간 시간으로 스크럽을 제한하는 것이 좋습니다. 예를 들면 다음과 같습니다.

[osd] osd_scrub_begin_hour = 23 #23:01H, or 10:01PM. osd_scrub_end_hour = 6 #06:01H or 6:01AM.

[osd]

osd_scrub_begin_hour = 23 #23:01H, or 10:01PM.

osd_scrub_end_hour = 6 #06:01H or 6:01AM.

시간 제약 조건이 스크럽 스케줄을 결정하는 효과적인 방법이 아닌 경우 osd_scrub_load_threshold 를 사용하는 것이 좋습니다. 기본값은 0.5 이지만 낮은 로드 조건을 위해 수정할 수 있습니다. 예를 들면 다음과 같습니다.

[osd] osd_scrub_load_threshold = 0.25

[osd]

osd_scrub_load_threshold = 0.252.13. objecter_inflight_ops증가

확장성을 개선하기 위해 허용되는 의도하지 않은 I/O 요청의 최대 수를 지정하는 objecter_inflight_ops 매개변수 값을 편집할 수 있습니다. 이 매개변수는 클라이언트 트래픽 제어에 사용됩니다.

objecter_inflight_ops = 24576

objecter_inflight_ops = 245762.14. Increase rgw_thread_pool_size

확장성을 개선하기 위해 스레드 풀의 크기인 rgw_thread_pool_size 매개변수 값을 편집할 수 있습니다. 새로운 Fence frontend 는 새로운 연결을 수락하기 위해 스레드 풀 크기에 의해 제한되지 않습니다.

rgw_thread_pool_size = 512

rgw_thread_pool_size = 5122.15. Ceph를 실행할 때 Linux 커널 튜닝 고려 사항

프로덕션 Red Hat Ceph Storage 클러스터는 일반적으로 운영 체제 조정, 특히 제한 및 메모리 할당의 이점을 제공합니다. 스토리지 클러스터 내의 모든 호스트에 대해 조정이 설정되어 있는지 확인합니다. 추가 지침을 요구하는 Red Hat 지원 케이스를 열 수도 있습니다.

파일 디스크립터 증가

Ceph Object Gateway는 파일 디스크립터가 부족하면 중지될 수 있습니다. Ceph Object Gateway 호스트에서 /etc/security/limits.conf 파일을 수정하여 Ceph Object Gateway의 파일 디스크립터를 늘릴 수 있습니다.

ceph soft nofile unlimited

ceph soft nofile unlimited대규모 스토리지 클러스터의 ulimit 값 조정

대규모 스토리지 클러스터에서 Ceph 관리 명령을 실행하는 경우(예: 1024 Ceph OSD 이상) 다음 내용으로 관리 명령을 실행하는 각 호스트에 /etc/security/limits.d/50-ceph.conf 파일을 만듭니다.

USER_NAME soft nproc unlimited

USER_NAME soft nproc unlimitedUSER_NAME을 Ceph 관리 명령을 실행하는 루트가 아닌 사용자 계정의 이름으로 바꿉니다.

루트 사용자의 ulimit 값은 Red Hat Enterprise Linux에서 기본적으로 ulimit으로 이미 설정되어 있습니다.

3장. Deployment

스토리지 관리자는 명령줄 인터페이스 또는 서비스 사양과 함께 Ceph Orchestrator를 사용하여 Ceph Object Gateway를 배포할 수 있습니다. 다중 사이트 Ceph Object Gateway를 구성하고 Ceph Orchestrator를 사용하여 Ceph Object Gateway를 제거할 수도 있습니다.

cephadm 명령은 Ceph Object Gateway를 다중 사이트 배포에서 단일 클러스터 배포 또는 특정 영역 및 영역을 관리하는 데몬 컬렉션으로 배포합니다.

cephadm 에서는 ceph.conf 파일 또는 명령줄 옵션 대신 Ceph Monitor 구성 데이터베이스를 사용하여 Ceph Object Gateway 데몬이 구성됩니다. 구성이 client.rgw 섹션에 없는 경우 Ceph Object Gateway 데몬은 기본 설정으로 시작하여 포트 80 에 바인딩합니다.

이 섹션에서는 다음 관리 작업에 대해 설명합니다.

사전 요구 사항

- 실행 중이고 정상적인 Red Hat Ceph Storage 클러스터입니다.

- 모든 노드에 대한 루트 수준 액세스.

- 스토리지 클러스터에서 사용 가능한 노드

- 모든 관리자, 모니터 및 OSD는 스토리지 클러스터에 배포됩니다.

3.1. 명령줄 인터페이스를 사용하여 Ceph Object Gateway 배포

Ceph Orchestrator를 사용하여 명령줄 인터페이스에서 ceph orch 명령을 사용하여 Ceph Object Gateway를 배포할 수 있습니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 모든 노드에 대한 루트 수준 액세스.

- 호스트가 클러스터에 추가됩니다.

- 모든 manager, monitor 및 OSD 데몬이 배포됩니다.

프로세스

Cephadm 쉘에 로그인합니다.

예제

cephadm shell

[root@host01 ~]# cephadm shellCopy to Clipboard Copied! Toggle word wrap Toggle overflow - Ceph 개체 게이트웨이 데몬은 다음과 같은 세 가지 방법으로 배포할 수 있습니다.

방법 1

영역, 영역 그룹, 영역을 생성한 다음 호스트 이름으로 배치 사양을 사용합니다.

영역을 생성합니다.

구문

radosgw-admin realm create --rgw-realm=REALM_NAME --default

radosgw-admin realm create --rgw-realm=REALM_NAME --defaultCopy to Clipboard Copied! Toggle word wrap Toggle overflow 예제

[ceph: root@host01 /]# radosgw-admin realm create --rgw-realm=test_realm --default

[ceph: root@host01 /]# radosgw-admin realm create --rgw-realm=test_realm --defaultCopy to Clipboard Copied! Toggle word wrap Toggle overflow 영역 그룹을 생성합니다.

구문

radosgw-admin zonegroup create --rgw-zonegroup=ZONE_GROUP_NAME --master --default

radosgw-admin zonegroup create --rgw-zonegroup=ZONE_GROUP_NAME --master --defaultCopy to Clipboard Copied! Toggle word wrap Toggle overflow 예제

[ceph: root@host01 /]# radosgw-admin zonegroup create --rgw-zonegroup=default --master --default

[ceph: root@host01 /]# radosgw-admin zonegroup create --rgw-zonegroup=default --master --defaultCopy to Clipboard Copied! Toggle word wrap Toggle overflow 영역을 생성합니다.

구문

radosgw-admin zone create --rgw-zonegroup=ZONE_GROUP_NAME --rgw-zone=ZONE_NAME --master --default

radosgw-admin zone create --rgw-zonegroup=ZONE_GROUP_NAME --rgw-zone=ZONE_NAME --master --defaultCopy to Clipboard Copied! Toggle word wrap Toggle overflow 예제

[ceph: root@host01 /]# radosgw-admin zone create --rgw-zonegroup=default --rgw-zone=test_zone --master --default

[ceph: root@host01 /]# radosgw-admin zone create --rgw-zonegroup=default --rgw-zone=test_zone --master --defaultCopy to Clipboard Copied! Toggle word wrap Toggle overflow 변경 사항을 커밋합니다.

구문

radosgw-admin period update --rgw-realm=REALM_NAME --commit

radosgw-admin period update --rgw-realm=REALM_NAME --commitCopy to Clipboard Copied! Toggle word wrap Toggle overflow 예제

[ceph: root@host01 /]# radosgw-admin period update --rgw-realm=test_realm --commit

[ceph: root@host01 /]# radosgw-admin period update --rgw-realm=test_realm --commitCopy to Clipboard Copied! Toggle word wrap Toggle overflow ceph orch apply명령을 실행합니다.구문

ceph orch apply rgw NAME [--realm=REALM_NAME] [--zone=ZONE_NAME] [--zonegroup=ZONE_GROUP_NAME] --placement="NUMBER_OF_DAEMONS [HOST_NAME_1 HOST_NAME_2]"

ceph orch apply rgw NAME [--realm=REALM_NAME] [--zone=ZONE_NAME] [--zonegroup=ZONE_GROUP_NAME] --placement="NUMBER_OF_DAEMONS [HOST_NAME_1 HOST_NAME_2]"Copy to Clipboard Copied! Toggle word wrap Toggle overflow 예제

[ceph: root@host01 /]# ceph orch apply rgw test --realm=test_realm --zone=test_zone --zonegroup=default --placement="2 host01 host02"

[ceph: root@host01 /]# ceph orch apply rgw test --realm=test_realm --zone=test_zone --zonegroup=default --placement="2 host01 host02"Copy to Clipboard Copied! Toggle word wrap Toggle overflow

방법 2

임의의 서비스 이름을 사용하여 단일 클러스터 배포를 위해 두 개의 Ceph Object Gateway 데몬을 배포합니다.

구문

ceph orch apply rgw SERVICE_NAME

ceph orch apply rgw SERVICE_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 예제

[ceph: root@host01 /]# ceph orch apply rgw foo

[ceph: root@host01 /]# ceph orch apply rgw fooCopy to Clipboard Copied! Toggle word wrap Toggle overflow

방법 3

레이블이 지정된 호스트 세트에서 임의의 서비스 이름을 사용합니다.

구문

ceph orch host label add HOST_NAME_1 LABEL_NAME ceph orch host label add HOSTNAME_2 LABEL_NAME ceph orch apply rgw SERVICE_NAME --placement="label:LABEL_NAME count-per-host:NUMBER_OF_DAEMONS" --port=8000

ceph orch host label add HOST_NAME_1 LABEL_NAME ceph orch host label add HOSTNAME_2 LABEL_NAME ceph orch apply rgw SERVICE_NAME --placement="label:LABEL_NAME count-per-host:NUMBER_OF_DAEMONS" --port=8000Copy to Clipboard Copied! Toggle word wrap Toggle overflow 참고NUMBER_OF_DAEMONS 는 각 호스트에 배포된 Ceph 개체 게이트웨이 수를 제어합니다. 추가 비용이 발생하지 않고 최고 성능을 달성하려면 이 값을 2로 설정합니다.

예제

[ceph: root@host01 /]# ceph orch host label add host01 rgw # the 'rgw' label can be anything [ceph: root@host01 /]# ceph orch host label add host02 rgw [ceph: root@host01 /]# ceph orch apply rgw foo --placement="label:rgw count-per-host:2" --port=8000

[ceph: root@host01 /]# ceph orch host label add host01 rgw # the 'rgw' label can be anything [ceph: root@host01 /]# ceph orch host label add host02 rgw [ceph: root@host01 /]# ceph orch apply rgw foo --placement="label:rgw count-per-host:2" --port=8000Copy to Clipboard Copied! Toggle word wrap Toggle overflow

검증

서비스를 나열합니다.

예제

[ceph: root@host01 /]# ceph orch ls

[ceph: root@host01 /]# ceph orch lsCopy to Clipboard Copied! Toggle word wrap Toggle overflow 호스트, 데몬 및 프로세스를 나열합니다.

구문

ceph orch ps --daemon_type=DAEMON_NAME

ceph orch ps --daemon_type=DAEMON_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 예제

[ceph: root@host01 /]# ceph orch ps --daemon_type=rgw

[ceph: root@host01 /]# ceph orch ps --daemon_type=rgwCopy to Clipboard Copied! Toggle word wrap Toggle overflow

3.2. 서비스 사양을 사용하여 Ceph Object Gateway 배포

기본 또는 사용자 지정 영역, 영역 및 영역 그룹과 함께 서비스 사양을 사용하여 Ceph Object Gateway를 배포할 수 있습니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 부트 스트랩된 호스트에 대한 루트 수준 액세스.

- 호스트가 클러스터에 추가됩니다.

- 모든 manager, monitor, OSD 데몬이 배포됩니다.

프로세스

root 사용자로 사양 파일을 생성합니다.

예제

touch radosgw.yml

[root@host01 ~]# touch radosgw.ymlCopy to Clipboard Copied! Toggle word wrap Toggle overflow Ceph Object 게이트웨이 종료/다시 시작 중에 rgw_graceful_stop 를 'true'로 설정하여

rgw_exit_timeout_secs매개변수에 정의된 기간 동안rgw_graceful_stop을 'true'로 설정하도록 S3 요청을 구성합니다.구문

ceph config set client.rgw rgw_graceful_stop true ceph config set client.rgw rgw_exit_timeout_secs 120

ceph config set client.rgw rgw_graceful_stop true ceph config set client.rgw rgw_exit_timeout_secs 120Copy to Clipboard Copied! Toggle word wrap Toggle overflow 참고컨테이너화된 배포의 경우

ceph orch stop/restart명령으로 예상대로 작동하려면--stop-timeout=120(또는 rgw_exit_timeout_secs 구성 값)의 추가extra_container_agrs구성도 필요합니다.Copy to Clipboard Copied! Toggle word wrap Toggle overflow 기본 영역, 영역, 영역 그룹에 대한 다음 세부 정보를 포함하도록

radosgw.yml파일을 편집합니다.구문

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 참고NUMBER_OF_DAEMONS 는 각 호스트에 배포된 Ceph Object Gateway 수를 제어합니다. 추가 비용이 발생하지 않고 최고 성능을 달성하려면 이 값을 2로 설정합니다.

예제

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 선택 사항: 사용자 지정 영역, 영역 및 영역 그룹의 경우 리소스를 생성한 다음

radosgw.yml파일을 생성합니다.사용자 지정 영역, 영역 및 영역 그룹을 생성합니다.

예제

radosgw-admin realm create --rgw-realm=test_realm --default radosgw-admin zonegroup create --rgw-zonegroup=test_zonegroup --default radosgw-admin zone create --rgw-zonegroup=test_zonegroup --rgw-zone=test_zone --default radosgw-admin period update --rgw-realm=test_realm --commit

[root@host01 ~]# radosgw-admin realm create --rgw-realm=test_realm --default [root@host01 ~]# radosgw-admin zonegroup create --rgw-zonegroup=test_zonegroup --default [root@host01 ~]# radosgw-admin zone create --rgw-zonegroup=test_zonegroup --rgw-zone=test_zone --default [root@host01 ~]# radosgw-admin period update --rgw-realm=test_realm --commitCopy to Clipboard Copied! Toggle word wrap Toggle overflow 다음 세부 정보를 사용하여

radosgw.yml파일을 생성합니다.예제

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

radosgw.yml파일을 컨테이너의 디렉터리에 마운트합니다.예제

cephadm shell --mount radosgw.yml:/var/lib/ceph/radosgw/radosgw.yml

[root@host01 ~]# cephadm shell --mount radosgw.yml:/var/lib/ceph/radosgw/radosgw.ymlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 참고쉘을 종료할 때마다 데몬을 배포하기 전에 컨테이너에 파일을 마운트해야 합니다.

서비스 사양을 사용하여 Ceph Object Gateway를 배포합니다.

구문

ceph orch apply -i FILE_NAME.yml

ceph orch apply -i FILE_NAME.ymlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 예제

[ceph: root@host01 /]# ceph orch apply -i /var/lib/ceph/radosgw/radosgw.yml

[ceph: root@host01 /]# ceph orch apply -i /var/lib/ceph/radosgw/radosgw.ymlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

검증

서비스를 나열합니다.

예제

[ceph: root@host01 /]# ceph orch ls

[ceph: root@host01 /]# ceph orch lsCopy to Clipboard Copied! Toggle word wrap Toggle overflow 호스트, 데몬 및 프로세스를 나열합니다.

구문

ceph orch ps --daemon_type=DAEMON_NAME

ceph orch ps --daemon_type=DAEMON_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 예제

[ceph: root@host01 /]# ceph orch ps --daemon_type=rgw

[ceph: root@host01 /]# ceph orch ps --daemon_type=rgwCopy to Clipboard Copied! Toggle word wrap Toggle overflow

3.3. Ceph Orchestrator를 사용하여 다중 사이트 Ceph Object Gateway 배포

Ceph Orchestrator는 Ceph Object Gateway에 대한 다중 사이트 구성 옵션을 지원합니다.

각 오브젝트 게이트웨이가 활성-활성 영역 구성에서 작동하도록 구성하여 기본이 아닌 영역에 쓰기를 허용할 수 있습니다. 다중 사이트 구성은 영역이라는 컨테이너 내에 저장됩니다.

영역은 영역 그룹, 영역 및 기간을 저장합니다. rgw 데몬은 별도의 동기화 에이전트가 필요하지 않은 동기화를 처리하므로 active-active 구성으로 작동합니다.

CLI(명령줄 인터페이스)를 사용하여 다중 사이트 영역을 배포할 수도 있습니다.

다음 구성에서는 두 개 이상의 Red Hat Ceph Storage 클러스터가 지리적으로 별도의 위치에 있다고 가정합니다. 그러나 구성은 동일한 사이트에서도 작동합니다.

사전 요구 사항

- 두 개 이상의 실행 중인 Red Hat Ceph Storage 클러스터

- 각 Red Hat Ceph Storage 클러스터에 하나씩 두 개 이상의 Ceph Object Gateway 인스턴스.

- 모든 노드에 대한 루트 수준 액세스.

- 노드 또는 컨테이너가 스토리지 클러스터에 추가됩니다.

- 모든 Ceph Manager, Monitor 및 OSD 데몬이 배포됩니다.

프로세스

cephadm쉘에서 기본 영역을 구성합니다.영역을 생성합니다.

구문

radosgw-admin realm create --rgw-realm=REALM_NAME --default

radosgw-admin realm create --rgw-realm=REALM_NAME --defaultCopy to Clipboard Copied! Toggle word wrap Toggle overflow 예제

[ceph: root@host01 /]# radosgw-admin realm create --rgw-realm=test_realm --default

[ceph: root@host01 /]# radosgw-admin realm create --rgw-realm=test_realm --defaultCopy to Clipboard Copied! Toggle word wrap Toggle overflow 스토리지 클러스터에 단일 영역이 있는 경우

--default플래그를 지정합니다.기본 영역 그룹을 생성합니다.

구문

radosgw-admin zonegroup create --rgw-zonegroup=ZONE_GROUP_NAME --endpoints=http://RGW_PRIMARY_HOSTNAME:RGW_PRIMARY_PORT_NUMBER_1 --master --default

radosgw-admin zonegroup create --rgw-zonegroup=ZONE_GROUP_NAME --endpoints=http://RGW_PRIMARY_HOSTNAME:RGW_PRIMARY_PORT_NUMBER_1 --master --defaultCopy to Clipboard Copied! Toggle word wrap Toggle overflow 예제

[ceph: root@host01 /]# radosgw-admin zonegroup create --rgw-zonegroup=us --endpoints=http://rgw1:80 --master --default

[ceph: root@host01 /]# radosgw-admin zonegroup create --rgw-zonegroup=us --endpoints=http://rgw1:80 --master --defaultCopy to Clipboard Copied! Toggle word wrap Toggle overflow 기본 영역을 생성합니다.

구문

radosgw-admin zone create --rgw-zonegroup=PRIMARY_ZONE_GROUP_NAME --rgw-zone=PRIMARY_ZONE_NAME --endpoints=http://RGW_PRIMARY_HOSTNAME:RGW_PRIMARY_PORT_NUMBER_1 --access-key=SYSTEM_ACCESS_KEY --secret=SYSTEM_SECRET_KEY

radosgw-admin zone create --rgw-zonegroup=PRIMARY_ZONE_GROUP_NAME --rgw-zone=PRIMARY_ZONE_NAME --endpoints=http://RGW_PRIMARY_HOSTNAME:RGW_PRIMARY_PORT_NUMBER_1 --access-key=SYSTEM_ACCESS_KEY --secret=SYSTEM_SECRET_KEYCopy to Clipboard Copied! Toggle word wrap Toggle overflow 예제

[ceph: root@host01 /]# radosgw-admin zone create --rgw-zonegroup=us --rgw-zone=us-east-1 --endpoints=http://rgw1:80 --access-key=LIPEYZJLTWXRKXS9LPJC --secret-key=IsAje0AVDNXNw48LjMAimpCpI7VaxJYSnfD0FFKQ

[ceph: root@host01 /]# radosgw-admin zone create --rgw-zonegroup=us --rgw-zone=us-east-1 --endpoints=http://rgw1:80 --access-key=LIPEYZJLTWXRKXS9LPJC --secret-key=IsAje0AVDNXNw48LjMAimpCpI7VaxJYSnfD0FFKQCopy to Clipboard Copied! Toggle word wrap Toggle overflow 선택 사항: 기본 영역, 영역 그룹 및 관련 풀을 삭제합니다.

중요데이터를 저장하기 위해 기본 영역 및 영역 그룹을 사용하는 경우 기본 영역 및 해당 풀을 삭제하지 마십시오. 또한 기본 영역 그룹을 제거하면 시스템 사용자가 삭제됩니다.

기본영역 및 zonegroup에서 이전 데이터에 액세스하려면radosgw-admin명령에서--rgw-zone default및--rgw-zonegroup 기본값을 사용합니다.예제

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 시스템 사용자를 생성합니다.

구문

radosgw-admin user create --uid=USER_NAME --display-name="USER_NAME" --access-key=SYSTEM_ACCESS_KEY --secret=SYSTEM_SECRET_KEY --system

radosgw-admin user create --uid=USER_NAME --display-name="USER_NAME" --access-key=SYSTEM_ACCESS_KEY --secret=SYSTEM_SECRET_KEY --systemCopy to Clipboard Copied! Toggle word wrap Toggle overflow 예제

[ceph: root@host01 /]# radosgw-admin user create --uid=zone.user --display-name="Zone user" --system

[ceph: root@host01 /]# radosgw-admin user create --uid=zone.user --display-name="Zone user" --systemCopy to Clipboard Copied! Toggle word wrap Toggle overflow access_key및secret_key를 기록합니다.기본 영역에 액세스 키와 시스템 키를 추가합니다.

구문

radosgw-admin zone modify --rgw-zone=PRIMARY_ZONE_NAME --access-key=ACCESS_KEY --secret=SECRET_KEY

radosgw-admin zone modify --rgw-zone=PRIMARY_ZONE_NAME --access-key=ACCESS_KEY --secret=SECRET_KEYCopy to Clipboard Copied! Toggle word wrap Toggle overflow 예제

[ceph: root@host01 /]# radosgw-admin zone modify --rgw-zone=us-east-1 --access-key=NE48APYCAODEPLKBCZVQ--secret=u24GHQWRE3yxxNBnFBzjM4jn14mFIckQ4EKL6LoW

[ceph: root@host01 /]# radosgw-admin zone modify --rgw-zone=us-east-1 --access-key=NE48APYCAODEPLKBCZVQ--secret=u24GHQWRE3yxxNBnFBzjM4jn14mFIckQ4EKL6LoWCopy to Clipboard Copied! Toggle word wrap Toggle overflow 변경 사항을 커밋합니다.

구문

radosgw-admin period update --commit

radosgw-admin period update --commitCopy to Clipboard Copied! Toggle word wrap Toggle overflow 예제

[ceph: root@host01 /]# radosgw-admin period update --commit

[ceph: root@host01 /]# radosgw-admin period update --commitCopy to Clipboard Copied! Toggle word wrap Toggle overflow cephadm쉘 외부에서 스토리지 클러스터 및 프로세스의FSID를 가져옵니다.예제

systemctl list-units | grep ceph

[root@host01 ~]# systemctl list-units | grep cephCopy to Clipboard Copied! Toggle word wrap Toggle overflow Ceph Object Gateway 데몬을 시작합니다.

구문

systemctl start ceph-FSID@DAEMON_NAME systemctl enable ceph-FSID@DAEMON_NAME

systemctl start ceph-FSID@DAEMON_NAME systemctl enable ceph-FSID@DAEMON_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 예제

systemctl start ceph-62a081a6-88aa-11eb-a367-001a4a000672@rgw.test_realm.us-east-1.host01.ahdtsw.service systemctl enable ceph-62a081a6-88aa-11eb-a367-001a4a000672@rgw.test_realm.us-east-1.host01.ahdtsw.service

[root@host01 ~]# systemctl start ceph-62a081a6-88aa-11eb-a367-001a4a000672@rgw.test_realm.us-east-1.host01.ahdtsw.service [root@host01 ~]# systemctl enable ceph-62a081a6-88aa-11eb-a367-001a4a000672@rgw.test_realm.us-east-1.host01.ahdtsw.serviceCopy to Clipboard Copied! Toggle word wrap Toggle overflow

Cephadm 쉘에서 보조 영역을 구성합니다.

호스트에서 기본 영역 구성을 가져옵니다.

구문

radosgw-admin realm pull --rgw-realm=PRIMARY_REALM --url=URL_TO_PRIMARY_ZONE_GATEWAY --access-key=ACCESS_KEY --secret-key=SECRET_KEY --default

radosgw-admin realm pull --rgw-realm=PRIMARY_REALM --url=URL_TO_PRIMARY_ZONE_GATEWAY --access-key=ACCESS_KEY --secret-key=SECRET_KEY --defaultCopy to Clipboard Copied! Toggle word wrap Toggle overflow 예제

[ceph: root@host04 /]# radosgw-admin realm pull --rgw-realm=test_realm --url=http://10.74.249.26:80 --access-key=LIPEYZJLTWXRKXS9LPJC --secret-key=IsAje0AVDNXNw48LjMAimpCpI7VaxJYSnfD0FFKQ --default

[ceph: root@host04 /]# radosgw-admin realm pull --rgw-realm=test_realm --url=http://10.74.249.26:80 --access-key=LIPEYZJLTWXRKXS9LPJC --secret-key=IsAje0AVDNXNw48LjMAimpCpI7VaxJYSnfD0FFKQ --defaultCopy to Clipboard Copied! Toggle word wrap Toggle overflow 호스트에서 기본 기간 구성을 가져옵니다.

구문

radosgw-admin period pull --url=URL_TO_PRIMARY_ZONE_GATEWAY --access-key=ACCESS_KEY --secret-key=SECRET_KEY

radosgw-admin period pull --url=URL_TO_PRIMARY_ZONE_GATEWAY --access-key=ACCESS_KEY --secret-key=SECRET_KEYCopy to Clipboard Copied! Toggle word wrap Toggle overflow 예제

[ceph: root@host04 /]# radosgw-admin period pull --url=http://10.74.249.26:80 --access-key=LIPEYZJLTWXRKXS9LPJC --secret-key=IsAje0AVDNXNw48LjMAimpCpI7VaxJYSnfD0FFKQ

[ceph: root@host04 /]# radosgw-admin period pull --url=http://10.74.249.26:80 --access-key=LIPEYZJLTWXRKXS9LPJC --secret-key=IsAje0AVDNXNw48LjMAimpCpI7VaxJYSnfD0FFKQCopy to Clipboard Copied! Toggle word wrap Toggle overflow 보조 영역을 구성합니다.

구문

radosgw-admin zone create --rgw-zonegroup=ZONE_GROUP_NAME \ --rgw-zone=SECONDARY_ZONE_NAME --endpoints=http://RGW_SECONDARY_HOSTNAME:RGW_PRIMARY_PORT_NUMBER_1 \ --access-key=SYSTEM_ACCESS_KEY --secret=SYSTEM_SECRET_KEY \ --endpoints=http://FQDN:80 \ [--read-only]radosgw-admin zone create --rgw-zonegroup=ZONE_GROUP_NAME \ --rgw-zone=SECONDARY_ZONE_NAME --endpoints=http://RGW_SECONDARY_HOSTNAME:RGW_PRIMARY_PORT_NUMBER_1 \ --access-key=SYSTEM_ACCESS_KEY --secret=SYSTEM_SECRET_KEY \ --endpoints=http://FQDN:80 \ [--read-only]Copy to Clipboard Copied! Toggle word wrap Toggle overflow 예제

[ceph: root@host04 /]# radosgw-admin zone create --rgw-zonegroup=us --rgw-zone=us-east-2 --endpoints=http://rgw2:80 --access-key=LIPEYZJLTWXRKXS9LPJC --secret-key=IsAje0AVDNXNw48LjMAimpCpI7VaxJYSnfD0FFKQ

[ceph: root@host04 /]# radosgw-admin zone create --rgw-zonegroup=us --rgw-zone=us-east-2 --endpoints=http://rgw2:80 --access-key=LIPEYZJLTWXRKXS9LPJC --secret-key=IsAje0AVDNXNw48LjMAimpCpI7VaxJYSnfD0FFKQCopy to Clipboard Copied! Toggle word wrap Toggle overflow 선택 사항: 기본 영역을 삭제합니다.

중요데이터를 저장하기 위해 기본 영역 및 영역 그룹을 사용하는 경우 기본 영역 및 해당 풀을 삭제하지 마십시오.

기본영역 및 zonegroup에서 이전 데이터에 액세스하려면radosgw-admin명령에서--rgw-zone default및--rgw-zonegroup 기본값을 사용합니다.예제

Copy to Clipboard Copied! Toggle word wrap Toggle overflow Ceph 구성 데이터베이스를 업데이트합니다.

구문

ceph config set SERVICE_NAME rgw_zone SECONDARY_ZONE_NAME

ceph config set SERVICE_NAME rgw_zone SECONDARY_ZONE_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 예제

[ceph: root@host04 /]# ceph config set rgw rgw_zone us-east-2

[ceph: root@host04 /]# ceph config set rgw rgw_zone us-east-2Copy to Clipboard Copied! Toggle word wrap Toggle overflow 변경 사항을 커밋합니다.

구문

radosgw-admin period update --commit

radosgw-admin period update --commitCopy to Clipboard Copied! Toggle word wrap Toggle overflow 예제

[ceph: root@host04 /]# radosgw-admin period update --commit

[ceph: root@host04 /]# radosgw-admin period update --commitCopy to Clipboard Copied! Toggle word wrap Toggle overflow Cephadm 쉘 외부에서 스토리지 클러스터 및 프로세스의 FSID를 가져옵니다.

예제

systemctl list-units | grep ceph

[root@host04 ~]# systemctl list-units | grep cephCopy to Clipboard Copied! Toggle word wrap Toggle overflow Ceph Object Gateway 데몬을 시작합니다.

구문

systemctl start ceph-FSID@DAEMON_NAME systemctl enable ceph-FSID@DAEMON_NAME

systemctl start ceph-FSID@DAEMON_NAME systemctl enable ceph-FSID@DAEMON_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 예제

systemctl start ceph-62a081a6-88aa-11eb-a367-001a4a000672@rgw.test_realm.us-east-2.host04.ahdtsw.service systemctl enable ceph-62a081a6-88aa-11eb-a367-001a4a000672@rgw.test_realm.us-east-2.host04.ahdtsw.service

[root@host04 ~]# systemctl start ceph-62a081a6-88aa-11eb-a367-001a4a000672@rgw.test_realm.us-east-2.host04.ahdtsw.service [root@host04 ~]# systemctl enable ceph-62a081a6-88aa-11eb-a367-001a4a000672@rgw.test_realm.us-east-2.host04.ahdtsw.serviceCopy to Clipboard Copied! Toggle word wrap Toggle overflow

선택 사항: 배치 사양을 사용하여 다중 사이트 Ceph Object Gateway를 배포합니다.

구문

ceph orch apply rgw NAME --realm=REALM_NAME --zone=PRIMARY_ZONE_NAME --placement="NUMBER_OF_DAEMONS HOST_NAME_1 HOST_NAME_2"

ceph orch apply rgw NAME --realm=REALM_NAME --zone=PRIMARY_ZONE_NAME --placement="NUMBER_OF_DAEMONS HOST_NAME_1 HOST_NAME_2"Copy to Clipboard Copied! Toggle word wrap Toggle overflow 예제

[ceph: root@host04 /]# ceph orch apply rgw east --realm=test_realm --zone=us-east-1 --placement="2 host01 host02"

[ceph: root@host04 /]# ceph orch apply rgw east --realm=test_realm --zone=us-east-1 --placement="2 host01 host02"Copy to Clipboard Copied! Toggle word wrap Toggle overflow

검증

동기화 상태를 확인하여 배포를 확인합니다.

예제

[ceph: root@host04 /]# radosgw-admin sync status

[ceph: root@host04 /]# radosgw-admin sync statusCopy to Clipboard Copied! Toggle word wrap Toggle overflow

3.4. Ceph Orchestrator를 사용하여 Ceph Object Gateway 제거

ceph orch rm 명령을 사용하여 Ceph 개체 게이트웨이 데몬을 제거할 수 있습니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- 모든 노드에 대한 루트 수준 액세스.

- 호스트가 클러스터에 추가됩니다.

- 호스트에 배포된 하나 이상의 Ceph 오브젝트 게이트웨이 데몬입니다.

프로세스

Cephadm 쉘에 로그인합니다.

예제

cephadm shell

[root@host01 ~]# cephadm shellCopy to Clipboard Copied! Toggle word wrap Toggle overflow 서비스를 나열합니다.

예제

[ceph: root@host01 /]# ceph orch ls

[ceph: root@host01 /]# ceph orch lsCopy to Clipboard Copied! Toggle word wrap Toggle overflow 서비스를 제거합니다.

구문

ceph orch rm SERVICE_NAME

ceph orch rm SERVICE_NAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 예제

[ceph: root@host01 /]# ceph orch rm rgw.test_realm.test_zone_bb

[ceph: root@host01 /]# ceph orch rm rgw.test_realm.test_zone_bbCopy to Clipboard Copied! Toggle word wrap Toggle overflow

검증

호스트, 데몬 및 프로세스를 나열합니다.

구문

ceph orch ps

ceph orch psCopy to Clipboard Copied! Toggle word wrap Toggle overflow 예제

[ceph: root@host01 /]# ceph orch ps

[ceph: root@host01 /]# ceph orch psCopy to Clipboard Copied! Toggle word wrap Toggle overflow

3.5. Ceph Manager rgw 모듈 사용

스토리지 관리자는 rgw 모듈을 사용하여 Ceph Object Gateway, 단일 사이트 및 다중 사이트를 배포할 수 있습니다. Ceph Object 영역, zonegroup 및 다양한 관련 엔티티를 부트 스트랩하고 구성하는 데 도움이 됩니다.

새로 생성된 또는 기존 영역에 사용 가능한 토큰을 사용할 수 있습니다. 이 토큰은 영역 정보 및 해당 마스터 영역 끝점 인증 데이터를 캡슐화하는 base64 문자열입니다.

다중 사이트 구성에서 이러한 토큰을 사용하여 rgw zone create 명령을 사용하여 기본 클러스터의 마스터 영역과 동기화하는 다른 클러스터에 보조 영역을 생성하는 데 사용할 수 있습니다.

3.5.1. rgw 모듈을 사용하여 Ceph Object Gateway 배포

Ceph Object Gateway 영역을 부트 스트랩하면 새 영역 엔티티, 새 영역 그룹, 새 영역이 생성됩니다. rgw 모듈은 해당 Ceph Object Gateway 데몬을 생성하고 배포하도록 오케스트레이터에 지시합니다.

ceph mgr 모듈 enable . rgw 명령을 사용하여 rgw 모듈을 활성화합니다rgw 모듈을 활성화한 후 명령줄에서 인수를 전달하거나 yaml 사양 파일을 사용하여 영역을 부트스트랩합니다.

사전 요구 사항

- 하나 이상의 OSD가 배포된 실행 중인 Red Hat Ceph Storage 클러스터

프로세스

Cephadm 쉘에 로그인합니다.

예제

cephadm shell

[root@host01 ~]# cephadm shellCopy to Clipboard Copied! Toggle word wrap Toggle overflow 'rgw'module을 활성화합니다.

예제

[ceph: root@host01 /]# ceph mgr module enable rgw

[ceph: root@host01 /]# ceph mgr module enable rgwCopy to Clipboard Copied! Toggle word wrap Toggle overflow 명령줄 또는 yaml 사양 파일을 사용하여 Ceph Object Gateway 영역을 부트스트랩합니다.

옵션 1: 명령줄 인터페이스를 사용합니다.

구문

ceph rgw realm bootstrap [--realm name REALM_NAME] [--zonegroup-name ZONEGROUP_NAME] [--zone-name ZONE_NAME] [--port PORT_NUMBER] [--placement HOSTNAME] [--start-radosgw]

ceph rgw realm bootstrap [--realm name REALM_NAME] [--zonegroup-name ZONEGROUP_NAME] [--zone-name ZONE_NAME] [--port PORT_NUMBER] [--placement HOSTNAME] [--start-radosgw]Copy to Clipboard Copied! Toggle word wrap Toggle overflow 예제

[ceph: root@host01 /]# ceph rgw realm bootstrap --realm-name myrealm --zonegroup-name myzonegroup --zone-name myzone --port 5500 --placement="host01 host02" --start-radosgw Realm(s) created correctly. Please, use 'ceph rgw realm tokens' to get the token.

[ceph: root@host01 /]# ceph rgw realm bootstrap --realm-name myrealm --zonegroup-name myzonegroup --zone-name myzone --port 5500 --placement="host01 host02" --start-radosgw Realm(s) created correctly. Please, use 'ceph rgw realm tokens' to get the token.Copy to Clipboard Copied! Toggle word wrap Toggle overflow 옵션 2: yaml 사양 파일을 사용합니다.

root 사용자로 yaml 파일을 생성합니다.

구문

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 예제

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 선택 사항: 영역 부트스트랩 중에

hostnames매개변수를 zonegroup에 추가할 수 있습니다.구문

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 예제

Copy to Clipboard Copied! Toggle word wrap Toggle overflow YAML 파일을 컨테이너의 디렉터리에 마운트합니다.

예제

cephadm shell --mount rgw.yaml:/var/lib/ceph/rgw/rgw.yaml

[root@host01 ~]# cephadm shell --mount rgw.yaml:/var/lib/ceph/rgw/rgw.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 영역을 부트스트랩합니다.

예제

[ceph: root@host01 /]# ceph rgw realm bootstrap -i /var/lib/ceph/rgw/rgw.yaml

[ceph: root@host01 /]# ceph rgw realm bootstrap -i /var/lib/ceph/rgw/rgw.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 참고rgw모듈에서 사용하는 사양 파일은 오케스트레이터에서 사용하는 형식과 동일합니다. 따라서 SSL 인증서와 같은 고급 구성 기능을 포함하여 지원되는 모든 오케스트레이션 Ceph Object Gateway 매개변수를 제공할 수 있습니다.

사용 가능한 토큰을 나열합니다.

예제

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 참고Ceph Object Gateway 데몬이 배포되기 전에 위의 명령을 실행하면 엔드포인트가 없으므로 토큰이 없다는 메시지가 표시됩니다.

검증

오브젝트 게이트웨이 배포를 확인합니다.

예제

[ceph: root@host01 /]# ceph orch list --daemon-type=rgw NAME HOST PORTS STATUS REFRESHED AGE MEM USE MEM LIM VERSION IMAGE ID CONTAINER ID rgw.myrealm.myzonegroup.ceph-saya-6-osd-host01.eburst ceph-saya-6-osd-host01 *:80 running (111m) 9m ago 111m 82.3M - 17.2.6-22.el9cp 2d5b080de0b0 2f3eaca7e88e

[ceph: root@host01 /]# ceph orch list --daemon-type=rgw NAME HOST PORTS STATUS REFRESHED AGE MEM USE MEM LIM VERSION IMAGE ID CONTAINER ID rgw.myrealm.myzonegroup.ceph-saya-6-osd-host01.eburst ceph-saya-6-osd-host01 *:80 running (111m) 9m ago 111m 82.3M - 17.2.6-22.el9cp 2d5b080de0b0 2f3eaca7e88eCopy to Clipboard Copied! Toggle word wrap Toggle overflow 영역 부트스트랩을

통해 호스트이름이 추가되었는지 확인합니다.구문

radosgw-admin zonegroup get --rgw-zonegroup _zone_group_name_

radosgw-admin zonegroup get --rgw-zonegroup _zone_group_name_Copy to Clipboard Copied! Toggle word wrap Toggle overflow 예제

Copy to Clipboard Copied! Toggle word wrap Toggle overflow Ceph Object Gateway 사양 파일의

zonegroup_hostnames에 지정된 호스트 이름 목록은 zonegroups의hostnames섹션을 참조하십시오.

3.5.2. rgw 모듈을 사용하여 Ceph Object Gateway 다중 사이트 배포

Ceph Object Gateway 영역을 부트 스트랩하면 새 영역 엔티티, 새 영역 그룹, 새 영역이 생성됩니다. 다중 사이트 동기화 작업에 사용할 수 있는 새 시스템 사용자를 구성합니다. rgw 모듈은 해당 Ceph Object Gateway 데몬을 생성하고 배포하도록 오케스트레이터에 지시합니다.

ceph mgr 모듈 enable . rgw 명령을 사용하여 rgw 모듈을 활성화합니다rgw 모듈을 활성화한 후 명령줄에서 인수를 전달하거나 yaml 사양 파일을 사용하여 영역을 부트스트랩합니다.

사전 요구 사항

- 하나 이상의 OSD가 배포된 실행 중인 Red Hat Ceph Storage 클러스터

프로세스

Cephadm 쉘에 로그인합니다.

예제

cephadm shell

[root@host01 ~]# cephadm shellCopy to Clipboard Copied! Toggle word wrap Toggle overflow 'rgw'module을 활성화합니다.

예제

[ceph: root@host01 /]# ceph mgr module enable rgw

[ceph: root@host01 /]# ceph mgr module enable rgwCopy to Clipboard Copied! Toggle word wrap Toggle overflow 명령줄 또는 yaml 사양 파일을 사용하여 Ceph Object Gateway 영역을 부트스트랩합니다.

옵션 1: 명령줄 인터페이스를 사용합니다.

구문

ceph rgw realm bootstrap [--realm name REALM_NAME] [--zonegroup-name ZONEGROUP_NAME] [--zone-name ZONE_NAME] [--port PORT_NUMBER] [--placement HOSTNAME] [--start-radosgw]

ceph rgw realm bootstrap [--realm name REALM_NAME] [--zonegroup-name ZONEGROUP_NAME] [--zone-name ZONE_NAME] [--port PORT_NUMBER] [--placement HOSTNAME] [--start-radosgw]Copy to Clipboard Copied! Toggle word wrap Toggle overflow 예제

[ceph: root@host01 /]# ceph rgw realm bootstrap --realm-name myrealm --zonegroup-name myzonegroup --zone-name myzone --port 5500 --placement="host01 host02" --start-radosgw Realm(s) created correctly. Please, use 'ceph rgw realm tokens' to get the token.

[ceph: root@host01 /]# ceph rgw realm bootstrap --realm-name myrealm --zonegroup-name myzonegroup --zone-name myzone --port 5500 --placement="host01 host02" --start-radosgw Realm(s) created correctly. Please, use 'ceph rgw realm tokens' to get the token.Copy to Clipboard Copied! Toggle word wrap Toggle overflow 옵션 2: yaml 사양 파일을 사용합니다.

root 사용자로 yaml 파일을 생성합니다.

구문

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 예제

Copy to Clipboard Copied! Toggle word wrap Toggle overflow YAML 파일을 컨테이너의 디렉터리에 마운트합니다.

예제

cephadm shell --mount rgw.yaml:/var/lib/ceph/rgw/rgw.yaml

[root@host01 ~]# cephadm shell --mount rgw.yaml:/var/lib/ceph/rgw/rgw.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 영역을 부트스트랩합니다.

예제

[ceph: root@host01 /]# ceph rgw realm bootstrap -i /var/lib/ceph/rgw/rgw.yaml

[ceph: root@host01 /]# ceph rgw realm bootstrap -i /var/lib/ceph/rgw/rgw.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 참고rgw모듈에서 사용하는 사양 파일은 오케스트레이터에서 사용하는 형식과 동일합니다. 따라서 SSL 인증서와 같은 고급 구성 기능을 포함하여 지원되는 모든 오케스트레이션 Ceph Object Gateway 매개변수를 제공할 수 있습니다.

사용 가능한 토큰을 나열합니다.

예제

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 참고Ceph Object Gateway 데몬이 배포되기 전에 위의 명령을 실행하면 엔드포인트가 없으므로 토큰이 없다는 메시지가 표시됩니다.

이러한 토큰을 사용하여 보조 영역을 생성하고 기존 영역에 결합합니다.

root 사용자로 yaml 파일을 생성합니다.

예제

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 컨테이너의 디렉터리에

zone-spec.yaml파일을 마운트합니다.예제

cephadm shell --mount zone-spec.yaml:/var/lib/ceph/radosgw/zone-spec.yaml

[root@host01 ~]# cephadm shell --mount zone-spec.yaml:/var/lib/ceph/radosgw/zone-spec.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 보조 영역에서 rgw'module을 활성화합니다.

예제

[ceph: root@host01 /]# ceph mgr module enable rgw

[ceph: root@host01 /]# ceph mgr module enable rgwCopy to Clipboard Copied! Toggle word wrap Toggle overflow 보조 영역을 생성합니다.

예제

[ceph: root@host01 /]# ceph rgw zone create -i /var/lib/ceph/radosgw/zone-spec.yaml

[ceph: root@host01 /]# ceph rgw zone create -i /var/lib/ceph/radosgw/zone-spec.yamlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

검증

Object Gateway 다중 사이트 배포를 확인합니다.

예제

Copy to Clipboard Copied! Toggle word wrap Toggle overflow

4장. 기본 설정

스토리지 관리자는 Ceph Object Gateway 구성의 기본 사항을 배우는 것이 중요합니다. 기본값과 Beast라는 포함된 웹 서버에 대해 알아볼 수 있습니다. Ceph Object Gateway 관련 문제 해결의 경우 Ceph Object Gateway에서 생성한 로깅 및 디버깅 출력을 조정할 수 있습니다. 또한 Ceph Object Gateway를 사용하여 스토리지 클러스터 액세스에 고가용성 프록시를 제공할 수 있습니다.

사전 요구 사항

- 실행 중이고 정상적인 Red Hat Ceph Storage 클러스터입니다.

- Ceph Object Gateway 소프트웨어 패키지 설치.

4.1. DNS에 와일드카드 추가

호스트 이름과 같은 와일드카드를 DNS 서버의 DNS 레코드에 추가할 수 있습니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- Ceph 개체 게이트웨이가 설치되어 있어야 합니다.

- 관리 노드에 대한 루트 수준 액세스.

프로세스

S3 스타일 하위 도메인이 있는 Ceph를 사용하려면

ceph-radosgw데몬이 도메인 이름을 확인하는 데 사용하는 DNS 서버의 DNS 레코드에 와일드카드를 추가합니다.구문

bucket-name.domain-name.com

bucket-name.domain-name.comCopy to Clipboard Copied! Toggle word wrap Toggle overflow dnsmasq의 경우 앞에 호스트 이름 앞에 점(.)을 추가하여 다음 주소 설정을 추가합니다.구문

address=/.HOSTNAME_OR_FQDN/HOST_IP_ADDRESS

address=/.HOSTNAME_OR_FQDN/HOST_IP_ADDRESSCopy to Clipboard Copied! Toggle word wrap Toggle overflow 예제

address=/.gateway-host01/192.168.122.75

address=/.gateway-host01/192.168.122.75Copy to Clipboard Copied! Toggle word wrap Toggle overflow bind의 경우 DNS 레코드에 와일드카드를 추가합니다.예제

Copy to Clipboard Copied! Toggle word wrap Toggle overflow DNS 서버를 다시 시작하고 하위 도메인이 있는 서버를 ping하여

ceph-radosgw데몬이 하위 도메인 요청을 처리할 수 있는지 확인합니다.구문

ping mybucket.HOSTNAME

ping mybucket.HOSTNAMECopy to Clipboard Copied! Toggle word wrap Toggle overflow 예제

ping mybucket.gateway-host01

[root@host01 ~]# ping mybucket.gateway-host01Copy to Clipboard Copied! Toggle word wrap Toggle overflow -

DNS 서버가 로컬 시스템에 있는 경우 로컬 시스템의 nameserver 항목을 추가하여

/etc/resolv.conf를 수정해야 할 수 있습니다. Ceph Object Gateway 영역 그룹에 호스트 이름을 추가합니다.

영역 그룹을 가져옵니다.

구문

radosgw-admin zonegroup get --rgw-zonegroup=ZONEGROUP_NAME > zonegroup.json

radosgw-admin zonegroup get --rgw-zonegroup=ZONEGROUP_NAME > zonegroup.jsonCopy to Clipboard Copied! Toggle word wrap Toggle overflow 예제

[ceph: root@host01 /]# radosgw-admin zonegroup get --rgw-zonegroup=us > zonegroup.json

[ceph: root@host01 /]# radosgw-admin zonegroup get --rgw-zonegroup=us > zonegroup.jsonCopy to Clipboard Copied! Toggle word wrap Toggle overflow JSON 파일을 백업합니다.

예제

[ceph: root@host01 /]# cp zonegroup.json zonegroup.backup.json

[ceph: root@host01 /]# cp zonegroup.json zonegroup.backup.jsonCopy to Clipboard Copied! Toggle word wrap Toggle overflow zonegroup.json파일을 확인합니다.예제

Copy to Clipboard Copied! Toggle word wrap Toggle overflow zonegroup.json파일을 새 호스트 이름으로 업데이트합니다.예제

"hostnames": ["host01", "host02","host03"],

"hostnames": ["host01", "host02","host03"],Copy to Clipboard Copied! Toggle word wrap Toggle overflow Ceph Object Gateway에서 영역 그룹을 다시 설정합니다.

구문

radosgw-admin zonegroup set --rgw-zonegroup=ZONEGROUP_NAME --infile=zonegroup.json

radosgw-admin zonegroup set --rgw-zonegroup=ZONEGROUP_NAME --infile=zonegroup.jsonCopy to Clipboard Copied! Toggle word wrap Toggle overflow 예제

[ceph: root@host01 /]# radosgw-admin zonegroup set --rgw-zonegroup=us --infile=zonegroup.json

[ceph: root@host01 /]# radosgw-admin zonegroup set --rgw-zonegroup=us --infile=zonegroup.jsonCopy to Clipboard Copied! Toggle word wrap Toggle overflow 기간을 업데이트합니다.

예제

[ceph: root@host01 /]# radosgw-admin period update --commit

[ceph: root@host01 /]# radosgw-admin period update --commitCopy to Clipboard Copied! Toggle word wrap Toggle overflow - DNS 설정이 적용되도록 Ceph Object Gateway를 다시 시작합니다.

4.2. Beast 프런트 엔드 웹 서버

Ceph Object Gateway는 C/C 내장 프런트 엔드 웹 서버인 Beast를 제공합니다. alal은 'Boost.Beast' C 라이브러리를 사용하여 HTTP를 구문 분석하고 비동기 네트워크 I/O를 위해 Boost.Asio 를 사용합니다.

4.3. al 구성 옵션

다음 Beast 구성 옵션은 RADOS 게이트웨이의 Ceph 구성 파일에 포함된 웹 서버에 전달할 수 있습니다. 각 옵션에는 기본값이 있습니다. 값을 지정하지 않으면 기본값은 비어 있습니다.

| 옵션 | 설명 | Default |

|---|---|---|

|

|

주소가 점으로 된 10진수 형식의 IPv4 주소 문자열 또는 대괄호로 묶은 16진수 표기법의 IPv6 주소 형식으로 수신 주소를 설정합니다. | 빈 |

|

| SSL 사용 엔드포인트에 사용되는 SSL 인증서 파일의 경로입니다. | 빈 |

|

|

SSL 사용 엔드포인트에 사용되는 개인 키 파일의 선택적 경로입니다. | 빈 |

|

| 일부 환경에서의 성능 최적화. | 빈 |

SSL을 사용하는 Beast 옵션이 있는 /etc/ceph/ceph.conf 파일의 예:

... [client.rgw.node1] rgw frontends = beast ssl_endpoint=192.168.0.100:443 ssl_certificate=<path to SSL certificate>

...

[client.rgw.node1]

rgw frontends = beast ssl_endpoint=192.168.0.100:443 ssl_certificate=<path to SSL certificate>기본적으로 Beast 프런트 엔드는 서버에서 처리하는 모든 요청을 RADOS 게이트웨이 로그 파일에 기록하는 액세스 로그 행을 작성합니다.

추가 리소스

- 자세한 내용은 Beast 프런트 엔드 사용을 참조하십시오.

4.4. Beast에 대한 SSL 구성

OpenSSL 라이브러리를 사용하여 TLS(Transport Layer Security)를 제공하도록 Beast 프런트 엔드 웹 서버를 구성할 수 있습니다. Beast와 함께 SSL(Secure Socket Layer)을 사용하려면 Ceph Object Gateway 노드의 호스트 이름과 일치하는 CA(인증 기관)에서 인증서를 가져와야 합니다. 또한al에는 시크릿 키, 서버 인증서 및 단일 .pem 파일에 있는 다른 CA도 필요합니다.

시크릿 키 해시가 포함되어 있으므로 .pem 파일에 대한 무단 액세스를 방지합니다.

Red Hat은 SAN(Subject Alternative Name) 필드를 사용하여 CA에서 인증서를 가져올 것을 권장하고 S3-style 하위 도메인에 사용할 와일드카드를 사용하는 것이 좋습니다.

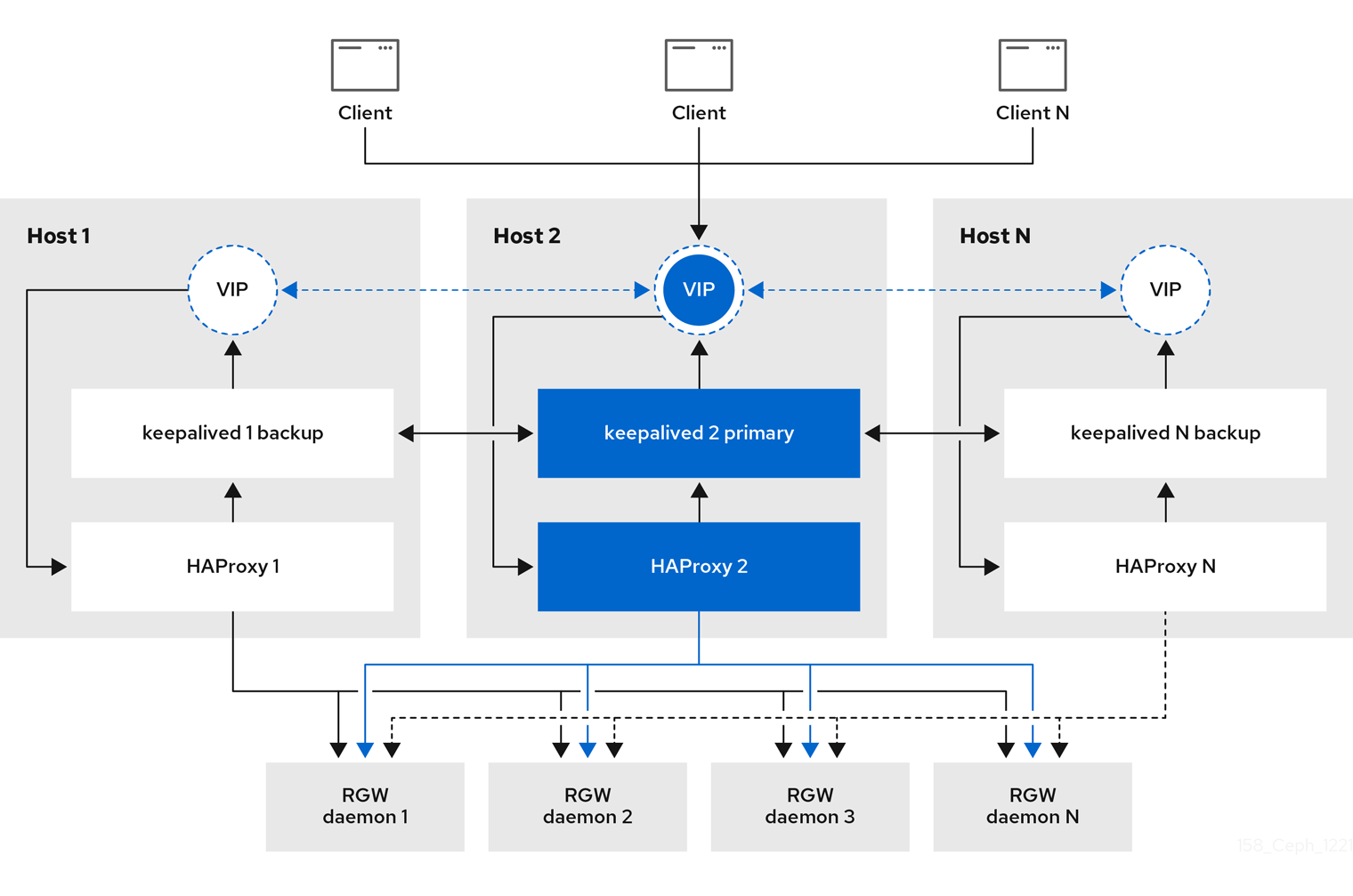

Red Hat Ceph Storage 7.0 스토리지 시스템의 경우 Red Hat은 소규모에서 중간 규모 테스트 환경을 위해 Beast 프런트 엔드 웹 서버가 있는 SSL만 사용하는 것이 좋습니다. 프로덕션 환경의 경우 HAProxy 및 keepalived 를 사용하여 HAProxy에서 SSL 연결을 종료해야 합니다.

Ceph Object Gateway가 클라이언트에서 작동하고 사용자 지정 인증서가 서버에서 사용되는 경우 노드에서 해당 인증서를 가져온 다음 Ceph Object Gateway 사양 파일에서 extra_container_args 매개변수를 사용하여 etc/pki 디렉터리를 컨테이너에 매핑할 수 있습니다.

사전 요구 사항

- 실행 중이고 정상적인 Red Hat Ceph Storage 클러스터입니다.

- Ceph Object Gateway 소프트웨어 패키지 설치.

- OpenSSL 소프트웨어 패키지를 설치합니다.

- Ceph Object Gateway 노드에 대한 루트 수준 액세스.

프로세스

현재 디렉터리에

rgw.yml이라는 새 파일을 생성합니다.예제

[ceph: root@host01 /]# touch rgw.yml

[ceph: root@host01 /]# touch rgw.ymlCopy to Clipboard Copied! Toggle word wrap Toggle overflow 편집을 위해

rgw.yml파일을 열고 환경에 맞게 사용자 지정합니다.구문

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 예제

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 서비스 사양 파일을 사용하여 Ceph Object Gateway를 배포합니다.

예제

[ceph: root@host01 /]# ceph orch apply -i rgw.yml

[ceph: root@host01 /]# ceph orch apply -i rgw.ymlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

4.5. D3N 데이터 캐시

datacenter-Data-Delivery Network(D3N)는 NVMe 와 같은 고속 스토리지를 사용하여 액세스 측의 데이터 집합을 캐시합니다. 이러한 캐싱을 사용하면 빅 데이터 작업에서 엣지의 각 Rados Gateway 노드에서 사용할 수 있는 컴퓨팅 및 빠른 저장소 리소스를 사용할 수 있습니다. Rados 게이트웨이는 백엔드 오브젝트 저장소(OSD)의 캐시 서버 역할을 하며 재사용을 위해 로컬로 데이터를 저장합니다.

Rados 게이트웨이를 다시 시작할 때마다 캐시 디렉터리의 콘텐츠가 제거됩니다.

4.5.1. D3N 캐시 디렉토리 추가

RGW에서 D3N 캐시를 활성화하려면 podman unit.run 에 D3N 캐시 디렉토리도 포함해야 합니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- Ceph 개체 게이트웨이가 설치되어 있어야 합니다.

- 관리 노드에 대한 루트 수준 액세스.

- 각 RGW 노드에 있는 빠른 NVMe 드라이브로 로컬 캐시 스토리지 역할을 합니다.

프로세스

NVMe 드라이브의 마운트 지점을 생성합니다.

구문

mkfs.ext4 nvme-drive-path

mkfs.ext4 nvme-drive-pathCopy to Clipboard Copied! Toggle word wrap Toggle overflow 예제

[ceph: root@host01 /]# mkfs.ext4 /dev/nvme0n1 mount /dev/nvme0n1 /mnt/nvme0n1/

[ceph: root@host01 /]# mkfs.ext4 /dev/nvme0n1 mount /dev/nvme0n1 /mnt/nvme0n1/Copy to Clipboard Copied! Toggle word wrap Toggle overflow 캐시 디렉터리 경로를 만듭니다.

구문

mkdir <nvme-mount-path>/cache-directory-name

mkdir <nvme-mount-path>/cache-directory-nameCopy to Clipboard Copied! Toggle word wrap Toggle overflow 예제

[ceph: root@host01 /]# mkdir /mnt/nvme0n1/rgw_datacache

[ceph: root@host01 /]# mkdir /mnt/nvme0n1/rgw_datacacheCopy to Clipboard Copied! Toggle word wrap Toggle overflow nvme-mount-path및rgw_d3n_l1_datacache_persistent_path에 +rwx 권한을 제공합니다.구문

chmod a+rwx nvme-mount-path ; chmod a+rwx rgw_d3n_l1_datacache_persistent_path

chmod a+rwx nvme-mount-path ; chmod a+rwx rgw_d3n_l1_datacache_persistent_pathCopy to Clipboard Copied! Toggle word wrap Toggle overflow 예제

[ceph: root@host01 /]# chmod a+rwx /mnt/nvme0n1 ; chmod a+rwx /mnt/nvme0n1/rgw_datacache/

[ceph: root@host01 /]# chmod a+rwx /mnt/nvme0n1 ; chmod a+rwx /mnt/nvme0n1/rgw_datacache/Copy to Clipboard Copied! Toggle word wrap Toggle overflow extra_container_args를 사용하여 RGW 사양 파일을 생성/수정하여rgw_d3n_l1_datacache_persistent_path를podman unit.run에 추가합니다.구문

"extra_container_args: "-v" "rgw_d3n_l1_datacache_persistent_path:rgw_d3n_l1_datacache_persistent_path" ""extra_container_args: "-v" "rgw_d3n_l1_datacache_persistent_path:rgw_d3n_l1_datacache_persistent_path" "Copy to Clipboard Copied! Toggle word wrap Toggle overflow 예제

Copy to Clipboard Copied! Toggle word wrap Toggle overflow 참고단일 호스트에 RGW 인스턴스가 여러 개인 경우 각 인스턴스에 대해 별도의

rgw_d3n_l1_datacache_persistent_path를 생성해야 하며extra_container_args에 각 경로를 추가해야 합니다.예:

각 호스트의 RGW 두 개의 인스턴스에 대해

rgw_d3n_l1_data cache_persistent_path:만듭니다./mnt/nvme0n1/rgw_datacache/rgw1및/mnt/nvme0n1/rgw_datacache/rgw2아래에 두 개의 별도의 캐시 디렉토리를rgw 사양 파일의 "extra_container_args"를 예로 들 수 있습니다.

Copy to Clipboard Copied! Toggle word wrap Toggle overflow rgw-spec.yml의 예::

Copy to Clipboard Copied! Toggle word wrap Toggle overflow RGW 서비스를 재배포합니다.

예제

[ceph: root@host01 /]# ceph orch apply -i rgw-spec.yml

[ceph: root@host01 /]# ceph orch apply -i rgw-spec.ymlCopy to Clipboard Copied! Toggle word wrap Toggle overflow

4.5.2. rados 게이트웨이에서 D3N 구성

기존 RGW에 D3N 데이터 캐시를 구성하여 Red Hat Ceph Storage 클러스터에서 실행되는 빅 데이터 작업의 성능을 향상시킬 수 있습니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- Ceph 개체 게이트웨이가 설치되어 있어야 합니다.

- 관리 노드에 대한 루트 수준 액세스.

- 캐시 스토리지 역할을 하는 빠른 NVMe입니다.

필요한 D3N 관련 구성 추가

기존 RGW에서 D3N을 활성화하려면 각 Rados 게이트웨이 클라이언트에 대해 다음 구성을 설정해야 합니다.

구문

ceph config set <client.rgw> <CONF-OPTION> <VALUE>

# ceph config set <client.rgw> <CONF-OPTION> <VALUE>-

rgw_d3n_l1_local_datacache_enabled=true rgw_d3n_l1_datacache_persistent_path= 캐시 디렉터리의경로예제

rgw_d3n_l1_datacache_persistent_path=/mnt/nvme/rgw_datacache/

rgw_d3n_l1_datacache_persistent_path=/mnt/nvme/rgw_datacache/Copy to Clipboard Copied! Toggle word wrap Toggle overflow rgw_d3n_l1_datacache_size=max_size_of_cache_in_bytes예제

rgw_d3n_l1_datacache_size=10737418240

rgw_d3n_l1_datacache_size=10737418240Copy to Clipboard Copied! Toggle word wrap Toggle overflow

절차 예

테스트 오브젝트를 생성합니다.

참고테스트 오브젝트는 캐시하려면 4MB보다 커야 합니다.

예제

[ceph: root@host01 /]# fallocate -l 1G ./1G.dat [ceph: root@host01 /]# s3cmd mb s3://bkt [ceph: root@host01 /]# s3cmd put ./1G.dat s3://bkt

[ceph: root@host01 /]# fallocate -l 1G ./1G.dat [ceph: root@host01 /]# s3cmd mb s3://bkt [ceph: root@host01 /]# s3cmd put ./1G.dat s3://bktCopy to Clipboard Copied! Toggle word wrap Toggle overflow GET오브젝트를 수행합니다.예제

[ceph: root@host01 /]# s3cmd get s3://bkt/1G.dat /dev/shm/1G_get.dat download: 's3://bkt/1G.dat' -> './1G_get.dat' [1 of 1] 1073741824 of 1073741824 100% in 13s 73.94 MB/s done

[ceph: root@host01 /]# s3cmd get s3://bkt/1G.dat /dev/shm/1G_get.dat download: 's3://bkt/1G.dat' -> './1G_get.dat' [1 of 1] 1073741824 of 1073741824 100% in 13s 73.94 MB/s doneCopy to Clipboard Copied! Toggle word wrap Toggle overflow 캐시 생성을 확인합니다. 캐시는 구성된

rgw_d3n_l1_datacache_persistent_path내에 오브젝트키-이름으로구성된 이름으로 생성됩니다.예제

[ceph: root@host01 /]# ls -lh /mnt/nvme/rgw_datacache rw-rr. 1 ceph ceph 1.0M Jun 2 06:18 cc7f967c-0021-43b2-9fdf-23858e868663.615391.1_shadow.ZCiCtMWeu_19wb100JIEZ-o4tv2IyA_1

[ceph: root@host01 /]# ls -lh /mnt/nvme/rgw_datacache rw-rr. 1 ceph ceph 1.0M Jun 2 06:18 cc7f967c-0021-43b2-9fdf-23858e868663.615391.1_shadow.ZCiCtMWeu_19wb100JIEZ-o4tv2IyA_1Copy to Clipboard Copied! Toggle word wrap Toggle overflow 오브젝트에 대한 캐시가 생성되면 해당 오브젝트에 대한 다음

GET작업에서 캐시에서 액세스하면 더 빠르게 액세스할 수 있습니다.예제

[ceph: root@host01 /]# s3cmd get s3://bkt/1G.dat /dev/shm/1G_get.dat download: 's3://bkt/1G.dat' -> './1G_get.dat' [1 of 1] 1073741824 of 1073741824 100% in 6s 155.07 MB/s done

[ceph: root@host01 /]# s3cmd get s3://bkt/1G.dat /dev/shm/1G_get.dat download: 's3://bkt/1G.dat' -> './1G_get.dat' [1 of 1] 1073741824 of 1073741824 100% in 6s 155.07 MB/s doneCopy to Clipboard Copied! Toggle word wrap Toggle overflow 위 예제에서는 캐시 가속을 설명하기 위해 RAM 드라이브(

/dev/shm)에 씁니다.

4.6. 로깅 및 디버깅 출력 조정

설정 절차를 완료하면 로깅 출력을 확인하여 요구 사항을 충족하는지 확인합니다. 기본적으로 Ceph 데몬은 journald 에 기록되며 journalctl 명령을 사용하여 로그를 볼 수 있습니다. 또는 /var/log/ceph/CEPH_CLUSTER_ID/ 디렉터리에 있는 Ceph 데몬을 파일에 기록할 수도 있습니다.

상세 로깅은 시간당 1GB 이상의 데이터를 생성할 수 있습니다. 이러한 유형의 로깅은 운영 체제의 디스크가 잠재적으로 채워지고 운영 체제가 작동하지 않을 수 있습니다.

사전 요구 사항

- 실행 중인 Red Hat Ceph Storage 클러스터.

- Ceph Object Gateway 소프트웨어 설치.

프로세스

Ceph Object Gateway 로깅 출력을 늘리려면 다음 매개변수를 설정합니다.

구문

ceph config set client.rgw debug_rgw VALUE

ceph config set client.rgw debug_rgw VALUECopy to Clipboard Copied! Toggle word wrap Toggle overflow 예제

[ceph: root@host01 /]# ceph config set client.rgw debug_rgw 20

[ceph: root@host01 /]# ceph config set client.rgw debug_rgw 20Copy to Clipboard Copied! Toggle word wrap Toggle overflow 런타임 시 이러한 설정을 수정할 수도 있습니다.

구문

ceph --admin-daemon /var/run/ceph/ceph-client.rgw.NAME.asok config set debug_rgw VALUE

ceph --admin-daemon /var/run/ceph/ceph-client.rgw.NAME.asok config set debug_rgw VALUECopy to Clipboard Copied! Toggle word wrap Toggle overflow 예제

[ceph: root@host01 /]# ceph --admin-daemon /var/run/ceph/ceph-client.rgw.rgw.asok config set debug_rgw 20

[ceph: root@host01 /]# ceph --admin-daemon /var/run/ceph/ceph-client.rgw.rgw.asok config set debug_rgw 20Copy to Clipboard Copied! Toggle word wrap Toggle overflow

필요한 경우 출력을 파일에 기록하도록 Ceph 데몬을 구성할 수 있습니다.

log_to_file,mon_cluster_log_to_file옵션을true로 설정합니다.예제

[ceph: root@host01 /]# ceph config set global log_to_file true [ceph: root@host01 /]# ceph config set global mon_cluster_log_to_file true

[ceph: root@host01 /]# ceph config set global log_to_file true [ceph: root@host01 /]# ceph config set global mon_cluster_log_to_file trueCopy to Clipboard Copied! Toggle word wrap Toggle overflow

4.7. 정적 웹 호스팅

스토리지 관리자는 Ceph Object Gateway를 구성하여 S3 버킷에서 정적 웹 사이트를 호스팅할 수 있습니다. 기존 웹 사이트 호스팅에는 각 웹 사이트에 대한 웹 서버를 구성해야 하며, 콘텐츠가 동적으로 변경되지 않을 때 리소스를 비효율적으로 사용할 수 있습니다. 예를 들어 PHP, 서블릿, 데이터베이스, nodejs 등과 같은 서버 측 서비스를 사용하지 않는 사이트를 예로 들 수 있습니다. 이 접근 방식은 각 사이트에 대해 웹 서버를 사용하는 가상 머신을 설정하는 것보다 훨씬 경제적입니다.

사전 요구 사항

- 정상적이고 실행 중인 Red Hat Ceph Storage 클러스터입니다.

4.7.1. 정적 웹 호스팅 가정

정적 웹 호스팅에는 Red Hat Ceph Storage 클러스터를 실행하는 하나 이상의 Ceph Object Gateway 인스턴스와 정적 웹 사이트에 대해 두 개 이상의 Ceph Object Gateway 인스턴스가 필요합니다. Red Hat은 각 영역에 HA(고가용성) 프록시 및 keepalived 와 같은 로드 밸런서를 사용하는 여러 게이트웨이 인스턴스가 있다고 가정합니다.

Red Hat 은 표준 S3/Swift API와 정적 웹 호스팅을 동시에 배포하기 위해 Ceph Object Gateway 인스턴스 사용을 지원하지 않습니다.

4.7.2. 정적 웹 호스팅 요구 사항

정적 웹 호스팅 기능은 자체 API를 사용하므로 S3 버킷에서 정적 웹 사이트를 사용하도록 게이트웨이를 구성하려면 다음이 필요합니다.

- S3 정적 웹 호스팅은 표준 S3/Swift API 사용 사례에 사용되는 인스턴스와 별도의 Ceph Object Gateway 인스턴스를 사용합니다.

- S3 정적 웹 사이트를 호스팅하는 게이트웨이 인스턴스에는 표준 S3/Swift API 게이트웨이 인스턴스에서 별도의 겹치지 않는 도메인 이름이 있어야 합니다.

- S3 정적 웹 사이트를 호스팅하는 게이트웨이 인스턴스는 표준 S3/Swift API 게이트웨이 인스턴스와 별도의 공용 IP 주소를 사용해야 합니다.

- S3 정적 웹 사이트 로드 밸런싱을 호스팅하는 게이트웨이 인스턴스 및 필요한 경우 HAProxy/keepalived를 사용하여 SSL을 종료합니다.

4.7.3. 정적 웹 호스팅 게이트웨이 설정

정적 웹 호스팅에 대해 Ceph Object Gateway를 활성화하려면 다음 옵션을 설정합니다.

구문

ceph config set client.rgw OPTION VALUE

ceph config set client.rgw OPTION VALUE예제

[ceph: root@host01 /]# ceph config set client.rgw rgw_enable_static_website true [ceph: root@host01 /]# ceph config set client.rgw rgw_enable_apis s3,s3website [ceph: root@host01 /]# ceph config set client.rgw rgw_dns_name objects-zonegroup.example.com [ceph: root@host01 /]# ceph config set client.rgw rgw_dns_s3website_name objects-website-zonegroup.example.com [ceph: root@host01 /]# ceph config set client.rgw rgw_resolve_cname true

[ceph: root@host01 /]# ceph config set client.rgw rgw_enable_static_website true

[ceph: root@host01 /]# ceph config set client.rgw rgw_enable_apis s3,s3website

[ceph: root@host01 /]# ceph config set client.rgw rgw_dns_name objects-zonegroup.example.com

[ceph: root@host01 /]# ceph config set client.rgw rgw_dns_s3website_name objects-website-zonegroup.example.com

[ceph: root@host01 /]# ceph config set client.rgw rgw_resolve_cname true

rgw_enable_static_website 설정은 true 여야 합니다. rgw_enable_apis 설정은 s3website API를 활성화해야 합니다. rgw_dns_name 및 rgw_dns_s3website_name 설정은 정규화된 도메인을 제공해야 합니다. 사이트에서 정식 이름 확장을 사용하는 경우 rgw_resolve_cname 옵션을 true 로 설정합니다.

rgw_dns_name 및 rgw_dns_s3website_name 의 FQDN은 겹치 지 않아야 합니다.

4.7.4. 정적 웹 호스팅 DNS 구성

다음은 가정된 DNS 설정의 예입니다. 처음 두 행은 표준 S3 인터페이스를 사용하여 게이트웨이 인스턴스의 도메인을 지정하고 IPv4 및 IPv6 주소를 가리킵니다. 세 번째 줄은 표준 이름 확장을 사용하여 S3 버킷에 대한 와일드카드 CNAME 설정을 제공합니다. 네 번째 줄과 다섯 번째 줄은 S3 웹 사이트 인터페이스를 사용하여 게이트웨이 인스턴스의 도메인을 지정하고 해당 IPv4 및 IPv6 주소를 가리킵니다.

objects-zonegroup.domain.com. IN A 192.0.2.10 objects-zonegroup.domain.com. IN AAAA 2001:DB8::192:0:2:10 *.objects-zonegroup.domain.com. IN CNAME objects-zonegroup.domain.com. objects-website-zonegroup.domain.com. IN A 192.0.2.20 objects-website-zonegroup.domain.com. IN AAAA 2001:DB8::192:0:2:20

objects-zonegroup.domain.com. IN A 192.0.2.10

objects-zonegroup.domain.com. IN AAAA 2001:DB8::192:0:2:10

*.objects-zonegroup.domain.com. IN CNAME objects-zonegroup.domain.com.

objects-website-zonegroup.domain.com. IN A 192.0.2.20

objects-website-zonegroup.domain.com. IN AAAA 2001:DB8::192:0:2:20처음 두 줄의 IP 주소는 네 번째와 다섯 번째 줄의 IP 주소와 다릅니다.

다중 사이트 구성에서 Ceph Object Gateway를 사용하는 경우 라우팅 솔루션을 사용하여 트래픽을 클라이언트에 가장 가까운 게이트웨이로 라우팅하는 것이 좋습니다.

AWS(Amazon Web Service)에는 호스트 이름과 일치하도록 정적 웹 호스트 버킷이 필요합니다. Ceph는 DNS를 구성하는 몇 가지 방법을 제공하며 프록시에 일치하는 인증서가 있는 경우 HTTPS가 작동합니다.

하위 도메인의 버킷에 호스트 이름

AWS 스타일 S3 하위 도메인을 사용하려면 DNS 항목에서 요청을 모든 버킷으로 리디렉션할 수 있는 와일드카드를 사용합니다. DNS 항목은 다음과 같을 수 있습니다.

*.objects-website-zonegroup.domain.com. IN CNAME objects-website-zonegroup.domain.com.